Os geradores de imagens com IA tornaram-se a próxima grande novidade na Internet. Junte-se a nós neste blogue para descobrir qual seria o melhor gerador de imagens de IA do mercado. Stable Diffusion vs Midjourney vs DALL-E serão comparados para estudar e fazer a melhor escolha.

Primeira ronda: Meio da viagem vs Difusão Estável vs DALLE-2

Fundada por David Holz, a Midjourney descreve-se como “um laboratório de investigação independente que explora novos meios de pensamento e expande os poderes imaginativos da espécie humana”. A IA apresenta-te imagens com base nas tuas instruções de texto.

A geração de imagens por IA Midjourney é uma técnica de modelo generativo relativamente nova utilizada em tarefas de geração de imagens, como a síntese de imagens, a super-resolução de imagens e a edição de imagens. Em vez de gerar uma imagem de saída final com uma única entrada, o modelo gera uma série de imagens intermédias, que podem, em última análise, refinar e melhorar a imagem de saída final.

Esta técnica envolve a utilização de um gerador de meio percurso que refina as imagens intermédias ao longo de várias iterações e a imagem de saída final. O gerador de meio percurso actua em cima de um gerador grosseiro, que gera os vectores de ruído aleatório inicial utilizando o processo de difusão.

Mais informações sobre Preços e subscrição do Midjourney.

Prós da Midjourney

- Imagens de maior qualidade: A geração de imagens Midjourney AI produz imagens de alta qualidade através do refinamento de imagens intermédias que melhoram progressivamente a imagem de saída final.

- Requisitos computacionais reduzidos: O gerador midjourney utiliza uma configuração de modelo mais pequena e requer menos recursos computacionais, tornando-o mais acessível e menos dispendioso do que outros modelos generativos.

- Maior controlo sobre a saída: As imagens intermédias geradas durante o processo de formação permitem um maior controlo e personalização da imagem de saída, o que pode facilitar a produção de um tipo de saída desejado.

- Maior flexibilidade: Os geradores Midjourney podem ser utilizados para modificar imagens existentes, permitindo a criação de imagens únicas, personalizadas e originais com diferentes padrões, texturas, cores ou morfologias.

- Melhor convergência: A geração de imagens Midjourney demonstrou melhores propriedades de convergência, conduzindo a tempos de formação mais reduzidos e a uma convergência mais rápida para a imagem de saída pretendida, resultando assim num maior rendimento.

- Imagens com aspeto mais natural: Os geradores Midjourney produzem imagens mais realistas e naturais devido ao refinamento progressivo das imagens intermédias, o que resulta em melhores resultados finais.

Contras da Midjourney

- Arquitetura mais complexa: A arquitetura dos geradores Midjourney pode ser mais complicada do que a dos modelos tradicionais, sendo necessária uma compreensão da arquitetura para implementar o modelo de forma eficaz.

- Tempo de treino mais longo: Os geradores Midjourney podem ter tempos de treino mais longos do que os modelos generativos tradicionais.

- O custo de computação pode continuar a ser elevado: Embora o gerador de viagem intermédia possa ser configurado para utilizar menos recursos computacionais, o custo global de computação pode continuar a ser considerável.

- Dependência de grandes conjuntos de dados: A imagiologia de médio curso implica trabalhar com grandes conjuntos de dados para efeitos de formação e validação. Assim, os geradores de Midjourney dependem da quantidade e da qualidade dos dados de entrada disponíveis.

- Dificuldades de otimização: A otimização da geração de imagens no meio da viagem pode ser difícil, tornando necessário que o utilizador tenha um conhecimento e uma compreensão profundos da arquitetura para otimizar o desempenho do algoritmo.

- Aplicações limitadas: Até à data, os geradores Midjourney têm sido mais amplamente utilizados em tarefas de geração de imagens de IA, que têm limites quando se trata de outras aplicações para as quais os estados intermédios desconhecidos entre a entrada e a saída não estão bem definidos.

Resumo de Midjourney vs Difusão estável vs DALL-E:

A principal vantagem do Midjourney é o facto de poder produzir imagens de alta qualidade, apesar de utilizar uma configuração de modelo mais pequena e recursos computacionais inferiores. O Midjourney também oferece mais flexibilidade e personalização no processo de formação, oferecendo um maior controlo sobre a pré-visualização das imagens intermédias geradas para o resultado final. Por sua vez, as principais desvantagens do Midjourney estão relacionadas com as suas complexidades, dados, computação e requisitos de otimização. No entanto, à medida que as suas potenciais aplicações se expandem, as suas vantagens estão a ser aproveitadas para uma vasta gama de aplicações de geração de imagens de IA.

Segunda ronda: Midjourney vs Difusão estável vs DALLE-2

O termo “difusão estável” na geração de imagens de IA refere-se a uma técnica utilizada para gerar imagens realistas utilizando o processo de difusão. O processo de difusão é uma forma de modelação generativa que envolve a aplicação iterativa de um algoritmo de difusão a um vetor de ruído aleatório inicial, conduzindo a uma série de actualizações que resultam na eventual geração de uma nova imagem.

A difusão estável é uma modificação do método padrão de geração de imagens com base na difusão que enfatiza a produção de imagens mais estáveis e de maior qualidade. Uma vez que o processo de difusão envolve uma série de actualizações estocásticas, pode dar origem a artefactos de imagem, inconsistências e desfocagem no resultado final. Com a difusão estável, o algoritmo de difusão é modificado para incorporar uma função de regularização que estabiliza a dinâmica de atualização durante o processo de formação, resultando em imagens de saída realistas e de maior qualidade.

Em resumo, a difusão estável é uma técnica avançada para gerar imagens estáveis e de alta qualidade utilizando o processo de difusão. É utilizado para melhorar a eficácia dos modelos de geração de imagens de IA, resultando em imagens geradas de maior qualidade e mais consistentes, reduzindo simultaneamente os artefactos e as inconsistências das imagens.

Vistas de alguns

Exemplos de difusão estável

.

Prós da difusão estável

-

Imagens de maior qualidade: A difusão estável melhora a qualidade das imagens geradas ao reduzir a ocorrência de artefactos de imagem e desfocagem, criando imagens mais realistas.

- Elevada precisão: A difusão estável é uma excelente técnica para gerar modelos generativos de elevada precisão, o que ajuda a produzir imagens impressionantes e realistas.

- Consistência melhorada: A difusão estável reduz as inconsistências entre as imagens geradas, levando a um resultado final mais consistente e polido.

- Melhor manuseamento de grandes conjuntos de dados: A difusão estável está melhor equipada para lidar com grandes conjuntos de dados, o que a torna a escolha ideal para gerar imagens em projectos de grande escala.

- Treinamento mais rápido: A difusão estável requer menos iterações para convergir, tornando-a mais rápida e eficiente para gerar imagens de alta qualidade.

- Maior estabilidade: A função de regularização incorporada no algoritmo de difusão estável estabiliza as actualizações de difusão, conduzindo a uma melhor convergência do processo de formação.

Contras da difusão estável

- Maior complexidade: A difusão estável é uma técnica mais complexa do que outros modelos tradicionais utilizados para a geração de imagens, o que a torna mais exigente e requer mais recursos computacionais.

- Flexibilidade limitada: A difusão estável requer parâmetros de afinação específicos durante o processo de formação, o que pode limitar a flexibilidade do modelo e a sua adaptabilidade a diferentes tipos de dados de entrada.

- Requer grandes conjuntos de dados: A difusão estável requer grandes conjuntos de dados para uma formação eficaz, o que resulta num pré-processamento e curadoria de dados significativos, que podem ser dispendiosos e demorados.

- Possibilidade de sobreajuste: Os modelos de difusão estável podem ajustar-se demasiado aos dados de treino, resultando num desempenho reduzido na geração de imagens novas e não vistas.

- Requisitos de recursos computacionais: A difusão estável requer mais recursos computacionais, como GPUs topo de gama, devido à sua arquitetura complexa e à necessidade de grandes quantidades de dados de treino.

- Tempos de treino mais longos: A difusão estável treina mais lentamente do que os métodos tradicionais de geração de imagens devido à sua arquitetura complexa, o que pode levar a tempos de treino mais longos.

Resumo de Midjourney vs Difusão estável vs DALL-E:

Em resumo, a difusão estável tem vantagens e desvantagens. Várias vantagens incluem: produção de imagens de maior qualidade com maior estabilidade, formação mais rápida e manuseamento de grandes conjuntos de dados, maior consistência e elevada precisão. Estas vantagens tornam-na uma técnica valiosa para melhorar os modelos de geração de imagens de IA. No entanto, embora a difusão estável possa melhorar a qualidade das imagens geradas, requer uma afinação cuidadosa, grandes conjuntos de dados e recursos computacionais mais potentes. Assim, os profissionais devem pesar e equilibrar estes factores ao considerarem a utilização da difusão estável ou de técnicas mais tradicionais na geração de imagens de IA.

Ronda 3: Midjourney vs Difusão Estável vs DALLE-2

DALL-E 2 refere-se a uma versão melhorada de DALL-E, um modelo de linguagem de IA desenvolvido pela OpenAI em janeiro de 2021. DALL-E é uma aplicação geradora baseada em imagens que utiliza a arquitetura de transformador com a capacidade de criar imagens fotorrealistas a partir de descrições de texto em linguagem natural.

O DALL-E 2 tem uma capacidade melhorada em comparação com o seu modelo anterior, com a capacidade de realizar manipulações de imagem avançadas, como mover, rodar e inverter objectos dentro da imagem. O DALL-E 2 gera novas imagens com base nas entradas de texto, tendo uma melhor compreensão do texto natural e uma gama mais alargada de vocabulários para a descrição de imagens.

O DALL-E 2 funciona recebendo um texto em linguagem natural como entrada e utiliza os transformadores do modelo generativo para produzir as imagens de saída correspondentes. O modelo visualiza as descrições em linguagem natural através de mascaramento, um método de deteção de píxeis de imagem que envolve a modificação da imagem de design para corresponder à frase introduzida.

Receba informações detalhadas sobre DALL-E 2.

Prós de DALL-E 2

- Compreensão de linguagem natural aprimorada: O DALL-E 2 é uma versão melhorada do DALL-E, com melhores capacidades de compreensão de linguagem natural com base na arquitetura do transformador, tornando-o ideal para gerar imagens de alta qualidade a partir de entradas de texto.

- Manipulação avançada de imagens: O DALL-E 2 pode realizar manipulações avançadas de imagens, como mover, girar e inverter objetos na imagem, proporcionando maior flexibilidade e personalização das visualizações de saída.

- Personalização de imagens: O modelo DALL-E 2 pode criar resultados altamente personalizados, como padrões, designs e formas personalizados para objetos, refletindo diversas preferências do usuário e casos de uso de design específicos do usuário.

- Consistência de saída: O DALL-E 2 gera imagens consistentes a partir de uma determinada entrada de linguagem natural, tornando-o ideal para gerar material de marketing ou publicidade repetível para empresas.

- Geração bidirecional: DALL-E 2 pode produzir imagens para entradas e descrições de imagens e, inversamente, textos para uma dada imagem, permitindo assim a geração bidirecional.

- Vocabulário extenso: O DALL-E 2 possui um extenso vocabulário adequado para gerar imagens a partir de uma ampla gama de tópicos e descrições, levando a uma maior versatilidade em aplicações generativas.

Contras de DALL-E 2

- Realismo limitado: Embora o DALL-E 2 gere imagens de alta qualidade, pode haver um limite para o realismo dessas imagens quando comparadas às imagens da vida real. Esta limitação pode restringir a aplicação de imagens Dall-E construídas para pronúncias pormenorizadas.

- Gestão de recursos: O DALL-E 2 requer recursos computacionais avançados e mais potentes para gerar imagens altamente complexas, tornando-o menos acessível a indivíduos e empresas sem os recursos necessários para o sustentar.

- Requisito de entrada de texto: A geração de imagens produzida pelo DALL-E 2 depende da qualidade da entrada de linguagem natural, limitando o âmbito da geração de imagens à obtenção de uma descrição de texto correcta.

- Qualidade do texto de entrada: O DALL-E 2 requer não só um texto de entrada adequado, mas também um texto pormenorizado e bem estruturado para produzir imagens de saída altamente precisas e de qualidade.

- Aplicações limitadas: Como o DALL-E 2 é programado especificamente para gerar imagens fotorrealistas a partir de descrições de texto, seu escopo de aplicação é limitado a casos de uso específicos, como produção de imagens ou vídeos, marketing e publicidade, onde imagens complexas, personalizadas e realistas podem ter aplicações significativas.

Resumo de Midjourney vs Difusão Estável vs DALL-E :

Em geral, o DALL-E 2 tem vantagens claras, incluindo uma melhor compreensão da linguagem natural, personalização avançada, consistência de saída, geração bidirecional e vocabulário extenso. Estas vantagens fazem do DALL-E 2 uma ferramenta ideal para designers, publicitários e criativos que procuram gerar imagens de alta qualidade a partir de descrições de texto e adaptar os designs às necessidades específicas dos utilizadores. Por sua vez, algumas desvantagens incluem a necessidade de recursos mais potentes, a dependência da qualidade e da estrutura do texto de entrada, a gestão de imagens já criadas, o âmbito limitado das aplicações e o potencial limitado de realismo.

Midjourney vs Stable Diffusion vs DALL-E 2: Quem é o vencedor?

É difícil declarar uma “melhor técnica” entre Midjourney vs Stable Diffusion vs DALL-E 2, uma vez que os seus casos de utilização podem variar com base em aplicações específicas, disponibilidade de dados, recursos computacionais e qualidade de saída esperada.

- O Midjourney é útil para personalizar a saída e proporcionar mais controlo sobre o processo de geração. É computacionalmente eficiente e melhora os tempos de convergência, ao mesmo tempo que produz imagens de aspeto mais natural. A geração de imagens Midjourney é particularmente útil para gerar imagens de alta qualidade utilizando recursos computacionais limitados, o que a torna uma excelente escolha em aplicações baseadas em design e vídeo.

- A difusão estável, por outro lado, é útil para gerar imagens estáveis e de alta qualidade, reduzindo as inconsistências e os artefactos nas imagens. A função de regularização incorporada na Difusão Estável estabiliza a dinâmica de atualização durante o processo de formação, conduzindo a uma maior qualidade do resultado final. A difusão estável é adequada para gerar imagens de IA em aplicações de cuidados de saúde, alimentação, gestão de inventários, cadeias de abastecimento ou sustentabilidade ambiental.

- O DALL-E 2 é especializado na geração de imagens fotorrealistas a partir de texto em linguagem natural, fornecendo capacidades avançadas de manipulação e personalização de imagens com vocabulário extenso. O DALL-E 2 é uma excelente escolha quando as imagens personalizadas, a adesão a normas específicas do mercado/indústria e as imagens semelhantes à vida real têm potencialmente uma orientação elevada.

Embora as três técnicas tenham as suas vantagens e limitações, espera-se que os profissionais seleccionem com base na natureza dos dados, nos recursos computacionais, nas aplicações específicas, na qualidade desejada dos resultados, no tempo de formação e nos conhecimentos técnicos necessários para utilizar as técnicas de forma eficaz.

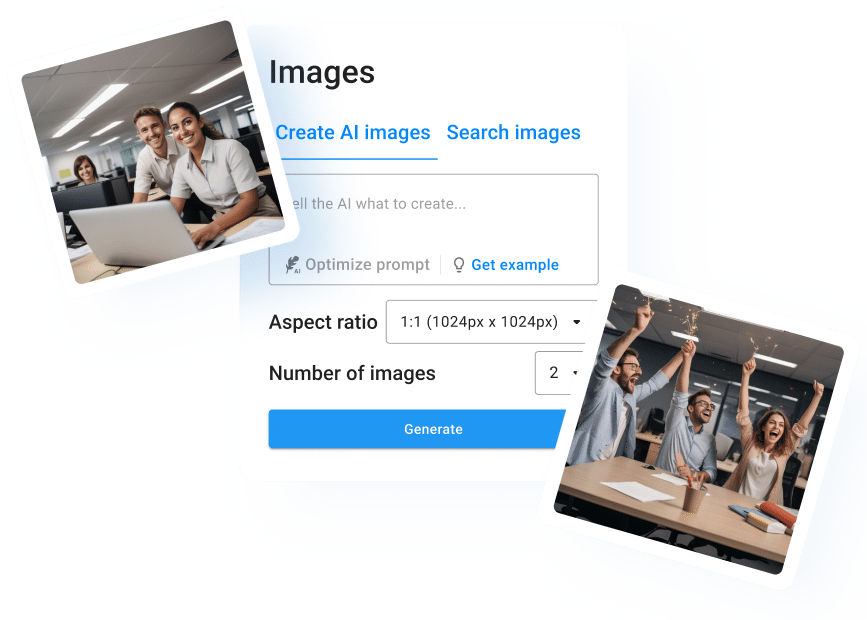

Quer experimentar a geração de imagens com IA gratuitamente? Então utilize o ImageFlash!

Para além destes três, existem muitos outros geradores de imagens de IA no mercado, e um deles é o ImageFlash, que funciona efetivamente com uma versão de um dos modelos Stable Diffusion. Por isso, se estiver à procura de um gerador de imagens AI que possa utilizar sem subscrição e gratuitamente, não procure mais! Com o ImageFlash, pode criar fotografias geradas por IA com uma simples descrição, totalmente grátis. Eis como funciona:

Visualize a imagem na sua mente e comunique a sua visão ao gerador de imagens neuroflash numa frase curta. Com a ajuda da nossa ferramenta de caneta mágica, nem sequer tem de pensar em como otimizar ainda mais o seu prompt. O neuroflash pode otimizar sem esforço e automaticamente o seu prompt e ajudá-lo a obter resultados ainda melhores:

Escolha o número de imagens que pretende que a IA gere para si. Pode selecionar até quatro imagens. Em seguida, o neuroflash processa o seu pedido e cria resultados correspondentes. Pode guardar, partilhar ou utilizar as suas imagens. Todas as imagens geradas pela IA são completamente livres de direitos de autor!

Imagens AI geradas por ImageFlash

Com o ImageFlash, é possível gerar todas as imagens que imagina no espaço de apenas alguns segundos; por isso, certifique-se de que utiliza uma descrição detalhada (prompt) para obter os melhores resultados. Experimente-o agora.

Perguntas mais frequentes:

DALL-E 2 é melhor do que Stable Diffusion?

DALL-E 2 e Stable Diffusion têm objectivos diferentes na geração de imagens de IA. A difusão estável é uma técnica que privilegia a estabilidade e a redução de artefactos durante o processo de geração de imagens, enquanto o DALL-E 2 é um modelo de linguagem de IA para gerar imagens fotorrealistas a partir de texto em linguagem natural.

A comparação direta das duas técnicas não é simples, uma vez que abordam casos de utilização específicos na geração de imagens. Ambos têm vantagens e desvantagens, sendo que o DALL-E 2 se concentra mais na capacidade de personalização, na manipulação avançada de imagens e na capacidade de utilizar texto em linguagem natural como entrada, enquanto o Stable Diffusion se concentra na geração de imagens estáveis e de alta qualidade com menos artefactos.

É melhor a Midjourney ou a Stable Diffusion?

Midjourney e Stable Diffusion são ambos modelos generativos que são úteis na geração de imagens de IA, mas são utilizados para fins diferentes. O Stable Diffusion centra-se na geração de imagens estáveis e de alta qualidade, reduzindo os artefactos, enquanto o Midjourney foi concebido para proporcionar um maior controlo e personalização do processo de geração de imagens.

Como tal, não existe uma técnica direta “melhor” entre a Midjourney e a Stable Diffusion, uma vez que os seus objectivos funcionais são diferentes. A geração de imagens Midjourney é mais eficiente em termos de potência computacional, requer menos dados para gerar resultados de alta qualidade e permite a personalização dos resultados da geração de imagens. A difusão estável, por outro lado, produz imagens estáveis e de alta qualidade através da aplicação de funções de regularização às actualizações de difusão, facilitando um resultado de qualidade superior.

Qual é a diferença entre DALL-E 2 e Midjourney?

O DALL-E 2 é um modelo de linguagem de IA que gera imagens fotorrealistas a partir de descrições de texto em linguagem natural; as suas capacidades generativas centram-se na criação de imagens altamente personalizadas e realistas com entrada de linguagem natural. O DALL-E 2 centra-se intimamente no aspeto linguístico e baseia-se num vocabulário extenso para gerar resultados de alta qualidade em conformidade com os requisitos de introdução de texto.

O Midjourney, por outro lado, é utilizado para fornecer imagens intermédias durante o processo de geração de imagens em tarefas de geração de imagens de IA. A sua vantagem particular reside no nível de controlo que se tem sobre o processo de geração de imagens. O Midjourney permite uma personalização eficiente das imagens geradas, com imagens intermédias que melhoram progressivamente o resultado final obtido em simultâneo.

Em resumo, a principal diferença entre DALL-E 2 e Midjourney é a técnica utilizada para gerar imagens. As simulações do DALL-E 2 baseiam-se em descrições de texto em linguagem natural, enquanto o Midjourney gera imagens intermédias para aumentar o controlo e as opções de personalização durante a produção de imagens. Consequentemente, são úteis para casos de utilização diferentes, sendo o DALL-E 2 eficaz na produção de imagens fotorrealistas a partir de linguagem natural e o Midjourney utilizado quando é necessário um maior controlo sobre o processo de geração de imagens.

A Midjourney baseia-se na Difusão Estável?

Midjourney e Stable Diffusion são duas técnicas diferentes de modelação generativa.

Midjourney é uma técnica que gera imagens intermédias durante o processo de geração de imagens, proporcionando mais controlo e opções de personalização no processo de geração de imagens. Os modelos de viagem intermédia podem funcionar em cima do processo de difusão estável, utilizando modelos de difusão para gerar imagens intermédias. No entanto, o Midjourney também pode ser utilizado em conjunto com outros modelos generativos.

A difusão estável, por outro lado, é uma técnica de modelação generativa que produz imagens estáveis e de alta qualidade, reduzindo os artefactos durante o processo de criação. Os modelos de difusão estável utilizam um processo de difusão que adiciona gradualmente ruído Gaussiano a uma imagem e depois remove-o, permitindo que o modelo gere distribuições complexas. Uma vez que as imagens intermédias não são criadas durante o processo de geração de imagens na difusão estável, a técnica não afecta diretamente a modelação Midjourney.

Qual é o futuro da IA?

Sem dúvida, há muitas razões para estarmos optimistas quanto ao futuro da IA. Em primeiro lugar, o rápido ritmo de progresso da tecnologia de IA não mostra sinais de abrandamento. Em segundo lugar, a IA está a ser cada vez mais utilizada numa variedade de indústrias e aplicações, o que só aumenta o seu impacto nas nossas vidas. Por último, o potencial da IA para ter um impacto positivo na humanidade é imenso. Então, o que podemos esperar da IA no futuro? Leia mais sobre o assunto aqui.

Como é que o gerador de imagens AI funciona?

Como já foi referido, Os geradores de imagens de Inteligência Artificial são programas de computador que criam novas imagens. Para criar um gerador de imagens com IA, é necessário conceber primeiro um “modelo generativo” de como as imagens são criadas, que se baseia num conjunto de regras que definem a forma como os elementos básicos de uma imagem podem ser combinados. Depois de o modelo generativo estar completo, pode gerar novas imagens. Existem dois tipos principais de geradores de imagens de IA: os que produzem imagens “fotorrealistas” e os que criam imagens “abstractas” ou “estilizadas”.

Como é que posso gerar imagens de IA?

Sem dúvidas, nossa principal recomendação relacionada com o melhor

O gerador de imagens AI será o neuroflash.

Mas não acredite apenas na nossa palavra – experimente o neuroflash hoje e veja os resultados por si próprio! Quer seja um designer profissional ou um amador, garantimos que esta poderosa ferramenta irá revolucionar a forma como aborda a criação de imagens para sempre.

Conclusão

Em resumo, entre Midjourney vs Stable Diffusion vs DALL-E 2, é difícil determinar qual é o melhor gerador de imagens de IA. Sem dúvida, todos eles oferecem vantagens e desvantagens diferentes. No final, cada pessoa decide por si qual o gerador que mais lhe convém. Caso contrário, se não conseguir decidir entre os três, pode sempre experimentar o gerador de imagens do neuroflash para criar fotografias fantásticas.