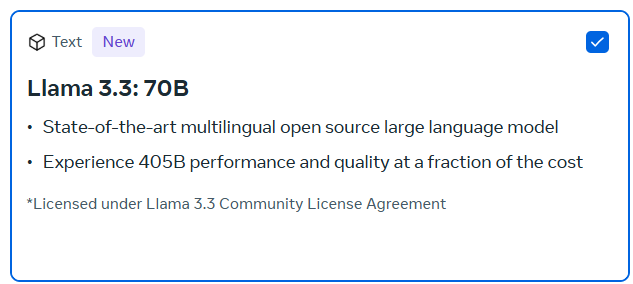

Meta hat gerade Llama 3.3 veröffentlicht, ein revolutionäres neues KI-Modell, das verspricht, die Art und Weise zu verändern, wie Entwickler, Unternehmen und Forscher künstliche Intelligenz nutzen. Mit einer leistungsstarken Architektur von 70 Milliarden Parametern und unglaublicher Effizienz setzt Llama 3.3 einen neuen Standard in der natürlichen Sprachverarbeitung (NLP).

In diesem Artikel tauchen wir in alles ein, was du über die Veröffentlichung von Llama 3.3 wissen musst, von den fortschrittlichen Funktionen bis hin zu praktischen Anwendungsfällen und Bereitstellungsoptionen. Egal, ob du ein Entwickler bist, der das Modell in deine Projekte integrieren möchte, oder ein Unternehmen, das sein Potenzial erkundet – dieser Leitfaden deckt alle wesentlichen Details ab.

Was Es Ist Llama 3.3?

Llama 3.3 ist Metas neuestes Sprachmodell in der Llama-Serie und baut auf der Grundlage seiner Vorgänger auf. Dieses 70 Milliarden-Parameter umfassende, anweisungstuned Modell wurde auf Effizienz optimiert und liefert hochleistungsfähige Ergebnisse trotz seiner kleineren Größe. Im Vergleich zu früheren Modellen wie Llama 3.1, das 405 Milliarden Parameter enthielt, bietet Llama 3.3 vergleichbare oder sogar überlegene Ergebnisse – was es zu einer idealen Wahl für diejenigen macht, die erstklassige KI-Leistung ohne hohe Rechenkosten suchen.

Key Features

1. Unerreichte Leistung mit effizienter Skalierung

Llama 3.3 zeigt eine überlegene Leistung, die mit größeren Modellen konkurriert, und erzielt außergewöhnliche Ergebnisse bei Aufgaben wie Texterstellung, Zusammenfassung, Fragebeantwortung und Übersetzung. Was Llama 3.3 auszeichnet, ist seine Fähigkeit, diese Ergebnisse mit deutlich weniger Parametern als ältere Modelle zu liefern.

Metas Fokus auf Effizienz bedeutet, dass Llama 3.3 weniger Rechenressourcen benötigt, was es einfacher macht, KI-Lösungen in verschiedenen Branchen wie Gesundheitswesen, Finanzen und Kundenservice zu skalieren. Dies macht es zu einer kostengünstigen Lösung für KI-gestützte Anwendungen.

Beispiel für einen Anwendungsfall: Stell dir vor, du baust einen KI-gesteuerten Kundenservice-Chatbot für eine globale Marke. Llama 3.3 kann mehrsprachige Interaktionen verarbeiten, präzise Antworten auf komplexe Anfragen liefern und nahtlos über verschiedene Regionen hinweg arbeiten – und das bei gleichzeitiger Minimierung der Serverkosten.

2. Mehrsprachige Fähigkeiten

Dieses Modell bietet ein leistungsstarkes mehrsprachiges Funktionsset und unterstützt acht Sprachen, darunter:

- Englisch

- Französisch

- Italienisch

- Portugiesisch

- Hindi

- Spanisch

- Thailändisch

- Deutsch

Diese mehrsprachige Kompetenz ermöglicht es Unternehmen, globalisierte KI-Lösungen zu entwickeln, die ein vielfältiges Publikum ansprechen. Egal, ob du Tools zur Inhaltserstellung, Kundenservice-Plattformen oder Bildungs-Chatbots erstellst, Llama 3.3 stellt sicher, dass Sprache niemals eine Barriere darstellt.

Beispiel für einen Anwendungsfall: Eine globale E-Commerce-Plattform könnte Llama 3.3 nutzen, um einen KI-Assistenten zu erstellen, der Kunden in mehreren Sprachen unterstützt und lokalisierte Produktempfehlungen sowie Unterstützung basierend auf der Sprache und Region des Kunden bietet.

3. Erweiterte Integration und Funktionsaufrufe

Llama 3.3 zeichnet sich nicht nur bei eigenständigen Aufgaben aus, sondern wurde auch mit fortschrittlichen Integrationsmöglichkeiten entwickelt. Es unterstützt Funktionsaufrufe, was bedeutet, dass es problemlos in bestehende KI-Systeme und Arbeitsabläufe integriert werden kann. Dies macht es für Entwickler, die Llama 3.3 in größere Anwendungen einbetten oder es zusammen mit anderen Tools verwenden möchten, äußerst nützlich.

Beispiel für einen Anwendungsfall: Entwickler können Llama 3.3 in eine Datenanalyse-Pipeline integrieren, um Aufgaben wie das Zusammenfassen von Berichten oder die Analyse von Kundenfeedback zu automatisieren. Das Modell kann Rohdaten verarbeiten, Zusammenfassungen erstellen und Funktionen auslösen, um Datenbanken zu aktualisieren oder Benachrichtigungen zu senden, wenn bestimmte Schwellenwerte erreicht werden.

Modellübersicht

Llama 3.3 ist ein hochgradig effizientes mehrsprachiges großes Sprachmodell (LLM), das von Meta entwickelt wurde und speziell für anweisungsbasierte Aufgaben konzipiert ist. Mit 70 Milliarden Parametern nutzt es eine Transformer-Architektur und wurde sowohl mit überwachten Lernmethoden als auch mit verstärkendem Lernen aus menschlichem Feedback (RLHF) feinabgestimmt. Dies stellt sicher, dass das Modell mit menschlichen Vorlieben übereinstimmt und sich auf Hilfsbereitschaft und Sicherheit bei den Antworten konzentriert.

Trainiert auf einer neuen Mischung öffentlich verfügbarer Online-Daten, ist Llama 3.3 für mehrsprachige Anwendungen optimiert und bietet textbasierte Eingaben und Ausgaben mit robusten Fähigkeiten sowohl in der Sprachgenerierung als auch in der Codeverarbeitung.

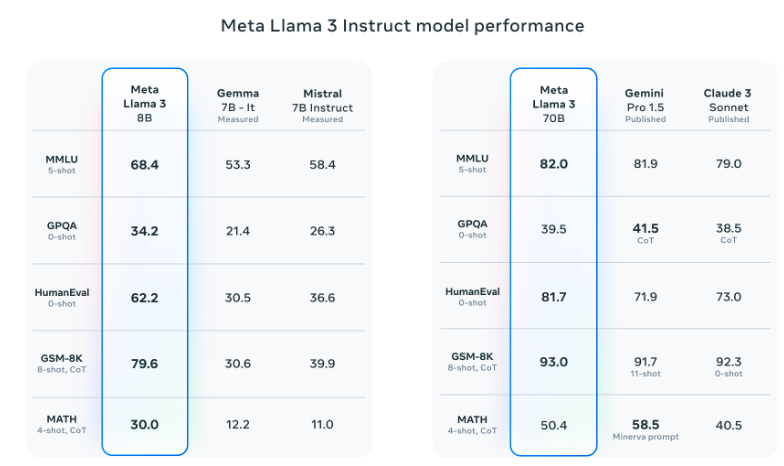

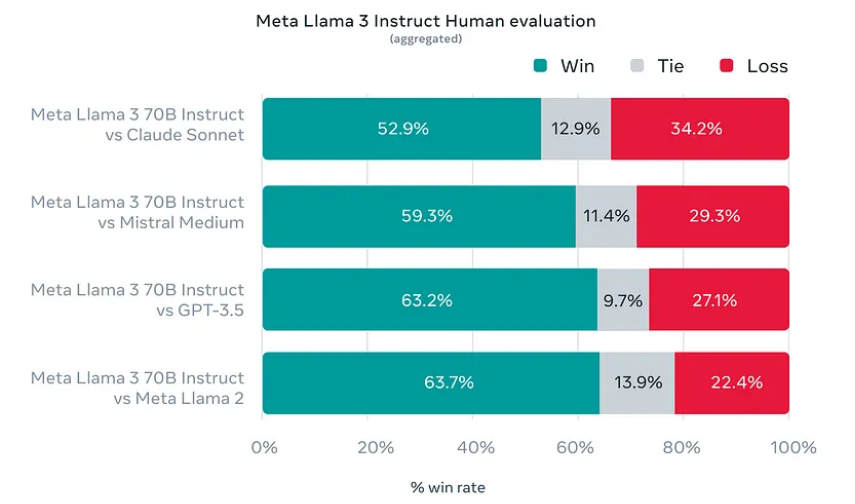

Das untenstehende Diagramm hebt die überlegene Leistung von Llama 3.3 im Vergleich zu bemerkenswerten Mitbewerbern wie Claude Sonnet, Mistral Medium und GPT-3.5 hervor. Diese Benchmarks konzentrieren sich auf Kategorien wie Denken, Programmierung, mehrsprachige Fähigkeiten und den Einsatz von Werkzeugen.

Key Benchmarks

MMLU (Massive Multitask Language Understanding): Llama 3.3 erzielte 86 % und zeigt seine Stärke bei mehrsprachigen Aufgaben.

HumanEval für Code-Generierung: Erreichte eine Pass@1-Rate von 88,4 % und übertraf GPT-3.5.

MGSM (Multilingual Grade School Math): Liefert eine führende Genauigkeit von 91,1 %.

Erkunde die vollständigen Benchmark-Daten hier.

Die Leistung des Modells sticht in verschiedenen Branchenbenchmarks hervor und übertrifft viele bestehende Open-Source- und Closed-Source-Chat-Modelle. Das große Trainingsset und die 128k Token-Kontextlänge machen es für lange, detaillierte Gespräche geeignet. Mit einem Wissensstand von Dezember 2023 ist Llama 3 eines der aktuellsten verfügbaren Sprachmodelle.

| Attribute | Details |

|---|---|

| Training Data | A new mix of publicly available online data. |

| Params | 70B |

| Input Modalities | Multilingual Text |

| Output Modalities | Multilingual Text and code |

| Context Length | 128k |

| GQA | Yes |

| Token Count | 15T+ |

| Knowledge Cutoff | December 2023 |

| Release Date | December 2023 |

Wie man auf Llama 3.3 zugreift

Llama 3.3 ist über Hugging Face verfügbar, eine beliebte Plattform für das Hosting und die Integration von KI-Modellen. Dies erleichtert Entwicklern das Erkunden, Testen und Bereitstellen dieses Modells für verschiedene Anwendungen. Gehe einfach zur Seite auf Hugging Face, um mit dem Herunterladen oder Ausführen des Modells direkt in der Cloud zu beginnen.

Zusätzlich stellt Meta detaillierte Modellkarten und Anleitungen zum Prompt-Format für Benutzer zur Verfügung, die ihre Interaktionen mit dem Modell anpassen möchten. Diese Ressourcen helfen dir dabei, Llamas Antworten auf spezifische Bedürfnisse zuzuschneiden.

Praktische Anwendungsfälle

1. Automatisierung der Kundenbetreuung

Llama 3.3 kann verwendet werden, um intelligente virtuelle Assistenten zu erstellen, die Kundenanfragen in verschiedenen Sprachen bearbeiten können. Durch die Bereitstellung schneller, präziser Antworten und das Verständnis des Benutzerkontexts kann Llama 3.3 die Kundenzufriedenheit erheblich steigern und gleichzeitig die Betriebskosten senken.

2. Die Erstellung von Inhalten und Personalisierung

KI-generierte Inhalte haben ein explosives Wachstum erlebt, und Llama 3.3 steht an der Spitze dieses Trends. Es kann Marketern helfen, Blogbeiträge, Produktbeschreibungen und sogar personalisierte Inhalte für verschiedene Segmente ihres Publikums zu erstellen, wodurch das Engagement und die Konversionsraten verbessert werden.

3. Pädagogische Werkzeuge

Mit seinen mehrsprachigen Fähigkeiten und seiner Effizienz kann Llama 3.3 verwendet werden, um KI-gesteuerte Lernwerkzeuge zu entwickeln, die Lernenden in mehreren Sprachen helfen, Echtzeit-Feedback geben und das Lernen basierend auf dem individuellen Fortschritt personalisieren.

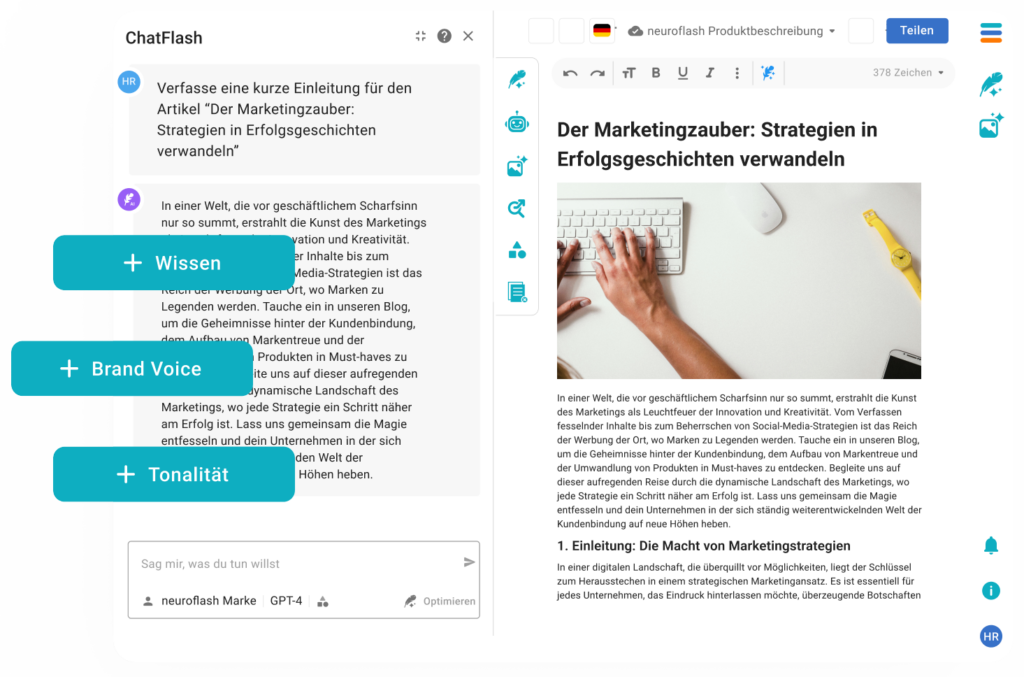

Die beste Alternative zu Llama 3.3 für die KI-Texterzeugung: neuroflash

Für diejenigen, die einen vielseitigen KI-Assistenten mit Zugriff auf mehrere Sprachmodelle, einschließlich Llama 3, suchen, ist ChatFlash von neuroflash eine ausgezeichnete Alternative. Im Gegensatz zu Lösungen, die an ein einzelnes Modell gebunden sind, ermöglicht ChatFlash die Nutzung der Stärken verschiedener LLMs. Es wurde entwickelt, um sowohl professionelle als auch alltägliche Aufgaben wie Inhaltserstellung, Paraphrasierung und gründliche Recherche zu bewältigen. Angetrieben von der fortschrittlichen GPT-4o-Technologie beschleunigt ChatFlash Arbeitsabläufe, minimiert den Aufwand und maximiert die Produktivität, wodurch es zu einem leistungsstarken Werkzeug für Unternehmen und Einzelpersonen wird.

Mit ChatFlash geht neuroflash über traditionelle KI-Assistenten hinaus und bietet intuitive Funktionen wie anpassbare Ton- und Stil-Einstellungen, die es an deine spezifischen Bedürfnisse anpassen.

Die Integrationsmöglichkeiten ermöglichen eine nahtlose Zusammenarbeit über Teams und Plattformen hinweg, sodass du in einem schnelllebigen Umfeld immer einen Schritt voraus bist. Durch die Kombination fortschrittlicher KI-Technologie mit benutzerzentriertem Design ermöglicht dir ChatFlash, mehr in kürzerer Zeit zu erreichen.

Entdecke, wie ChatFlash Produktivität und Kreativität in deinen Arbeitsabläufen neu definieren kann!

Fazit

Meta’s Llama 3.3 ist ein großer Fortschritt in der Welt der künstlichen Intelligenz. Die Kombination aus hoher Leistung, mehrsprachigen Fähigkeiten und Kosteneffizienz macht es zu einer idealen Lösung für eine Vielzahl von Branchen, von Tech-Startups bis hin zu globalen Unternehmen. Mit seinen nahtlosen Integrationsmöglichkeiten und benutzerfreundlichen Ressourcen ist es einfacher denn je, Llama 3.3 in deinen Projekten zu verwenden.