Meta hat kürzlich eine aktualisierte Version ihres beliebten Chatbots LLaMA2 Chat veröffentlicht. Diese neue Version wird von Perplexity Labs betrieben und verfügt über eine Vielzahl spannender Funktionen, die das Benutzererlebnis mit Sicherheit verbessern und das Chatten noch unterhaltsamer und ansprechender machen. In diesem Blogbeitrag werfen wir einen genaueren Blick auf die Neuerungen im LLaMA2 Chat und untersuchen, wie diese Updates sowohl Benutzern als auch Unternehmen zugutekommen können.

Was ist der LLaMA2 Chat von Perplexity AI?

Der LLaMA2 Chat von Perplexity ist eine neue und mit Spannung erwartete Ergänzung zur Welt der Chat-Tools. Als Bereicherung für Entwickler und Ersteller zielt es darauf ab, die Art und Weise, wie wir mit Benutzern und Daten interagieren, zu revolutionieren. Dieses Open-Source-Modell ermöglicht Vielseitigkeit und Anpassung und ist damit eine der besten verfügbaren Optionen. Der LLaMA2-Chat bietet einen Meta-Learning-Ansatz, bei dem vorab trainierte Modelle verwendet werden, um Eingabeaufforderungen und Antworten zu generieren. Dadurch kann der Chat im Laufe der Zeit lernen und sich anpassen, sodass Benutzer genauere und kontextbezogenere Antworten erhalten.

Darüber hinaus ist es durch die Integration mit Unity, GitHub und anderen Tools für Entwickler leicht zugänglich und bequem in ihre Projekte zu integrieren. Einer der Hauptvorteile von LLaMA2 Chat ist seine Fähigkeit, Daten zu speichern und zu analysieren, was detaillierte Berichte und Erkenntnisse ermöglicht. Es unterstützt auch die Verwendung von Cookies und sorgt so für ein nahtloses Benutzererlebnis. Mit seiner beeindruckenden Funktionsvielfalt und seinem Engagement für Innovation ist LLaMA2 Chat von Perplexity bereit, die Chat-Tool-Landschaft zu revolutionieren. Seien Sie gespannt auf die kommenden Abschnitte, um mehr über die Funktionen, Vorteile und Preispläne zu erfahren. Lesen Sie hier die Erklärung zur Unterstützung des offenen Ansatzes von Meta.

So lautet der Auszug aus dem offiziellen wissenschaftlichen Artikel über LLaMA 2 Chat:

"[...]We developed and release Llama 2, a collection of pretrained and fine-tuned large language models (LLMs) ranging in scale from 7 billion to 70 billion parameters. Our fine-tuned LLMs, called Llama 2-Chat, are optimized for dialogue use cases. Our models outperform open-source chat models on most benchmarks we tested, and based on our human evaluations for helpfulness and safety, may be a suitable substitute for closedsource models. We provide a detailed description of our approach to fine-tuning and safety improvements of Llama 2-Chat in order to enable the community to build on our work and contribute to the responsible development of LLMs."

Übersicht über die Funktionen im LLaMA2-Chat

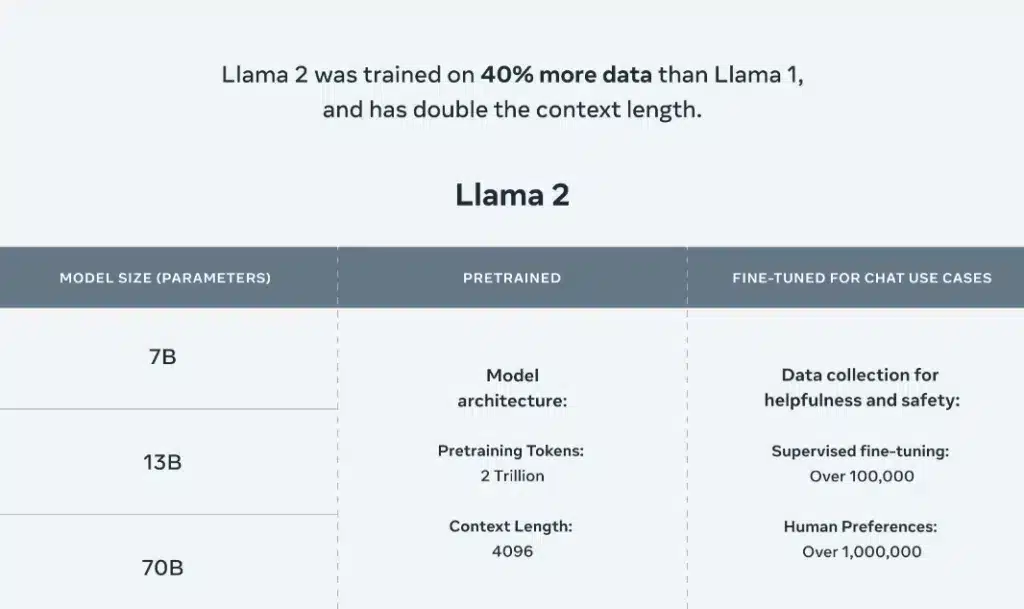

Meta bringt verschiedene Versionen seines LLAMA-Modells auf den Markt, die von 7 bis 70 Milliarden Basen reichen und eine Chat-Variante mit den gleichen Größen umfassen. Allerdings sind Metas Behauptungen, sie hätten diese Modelle verbessert, bestenfalls fragwürdig. Sie rühmen sich damit, die Größe des Pre-Training-Korpus um nur 40 % zu erhöhen, die Kontextlänge auf nur 4.000 Zeichen zu verdoppeln und die Aufmerksamkeit bei gruppierten Abfragen zu übernehmen – alles Techniken, die bereits im nächsten Jahr in der wissenschaftlichen Literatur veröffentlicht wurden! Es scheint, als ob Meta einfach versucht, auf bestehenden Forschungsergebnissen aufzubauen, anstatt sich selbst zu innovieren.

Der LLaMA2 Chat von Perplexity ist ein Open-Source-Chat-Modell, das durch seine neuen und innovativen Funktionen Aufmerksamkeit erregt hat. Einer der herausragenden Aspekte von LLaMA2 Chat ist sein robuster Satz an Tools und Funktionen. Von der Asset-Speicherung bis zur zeitnahen Schulung bietet dieses Chat-Modell eine Vielzahl von Funktionen, die auf unterschiedliche Bedürfnisse zugeschnitten sind.

Das derzeit angebotene LLM ist angeblich das kompetenteste Programm, das Einzelpersonen – von Wissenschaftlern bis hin zu Unternehmen – durch Direktkauf zugänglich ist. Diese Behauptung bedarf jedoch einer kritischen Würdigung.

LLaMA2 Chat - Ein Blick in die Technologie

Nach einem gründlichen Benchmarking können wir feststellen, dass dieses offene Modell qualitativ mit ChatGPT mithalten kann (mit Ausnahme der Codierung). Das ist durchaus bemerkenswert und verdient Anerkennung.

Obwohl Llama-2 noch nicht das Niveau von GPT-3.5 erreicht hat, liegt dies eher an seinen unterdurchschnittlichen Codierungsfähigkeiten als an einem inhärenten Fehler im Modell selbst. Im Vergleich zu StarCoder und anderen spezialisierten Modellen, die für die Codierung auf „HumanEval“ entwickelt wurden, bleibt Llama-2 deutlich zurück.

Training und Modelle

In Bezug auf Schulungen und Modelle bietet LLaMA2 Chat umfangreiche Möglichkeiten. Entwickler können Eingabeaufforderungen und Daten nutzen, um das Modell an ihre spezifischen Anforderungen anzupassen. Durch die Möglichkeit, Daten zu speichern und zu melden, können Benutzer wertvolle Erkenntnisse gewinnen und ihre Chat-Erlebnisse weiter optimieren. Darüber hinaus ermöglicht der GitHub-Link von LLaMA2 Chat Enthusiasten, zur Open-Source-Community beizutragen und die Gesamtfunktionalität des Modells zu verbessern.

Das neue Modell weist hinsichtlich der Architektur eine bemerkenswerte Ähnlichkeit mit dem ursprünglichen LLaMA auf, es wurden jedoch erhebliche Änderungen an Daten und Trainingsprozessen vorgenommen. Diese Änderungen werden die meisten unserer kommenden Beiträge ausmachen. Die Kontextlänge wurde für Chat-Anwendungsfälle erweitert, da sie für die Benutzerfreundlichkeit von entscheidender Bedeutung ist, während die Aufmerksamkeit bei gruppierten Abfragen (GQA) die Inferenzgeschwindigkeit erheblich erhöht.

Lizens

Das Modell ist ausschließlich für den kommerziellen Gebrauch erhältlich, allerdings mit einem Haken. Um berechtigt zu sein, muss Ihr Produkt mindestens 700 Millionen aktive Benutzer pro Monat haben. Doch bevor Sie das begehrte Tool überhaupt vom HuggingFace-Hub herunterladen können, müssen Sie ein Antragsformular ausfüllen, das praktischerweise in der dazugehörigen „Llama 2 Community-Lizenzvereinbarung“ versteckt ist.

Sicherheit

Die größte Verbesserung dieses Modells und Berichts sind zweifellos seine Sicherheitsfunktionen. Im Vergleich zu anderen auf dem Markt erhältlichen Open-Source-Modellen schneidet Falcon 40b-instruct in puncto Sicherheit trotz eines relativ milden Trainingsprozesses überraschend gut ab – aber lassen Sie uns diese Diskussion für einen anderen Tag aufheben. Dieser Abschnitt bietet eine Fülle von Informationen darüber, wie sich Sicherheit auf die verschiedenen Phasen der Schulung und Bewertung auswirkt. Während wir die Nutzung dieses Modells immer weiter vorantreiben, wird es faszinierend sein zu beobachten, wie sich diese Details entfalten, während KI heute mehr denn je einer öffentlichen Prüfung ausgesetzt ist!

Erfahre mehr über Perplexity AI und entdecke den Vergleich zwischen Perplexity AI vs ChatGPT.

Wie benutzt man den LLaMA2 Chat?

1. Besuche die Demo Website

- Gehe zu diesem Link.

- Sobald du auf der Webseite bist, scrolle weiter nach unten, bis du auf einen Abschnitt mit der Überschrift „Demo“ stößt.

- Dort findest du einen Chat-Box. Gehe voran und tippe eine Nachricht dort hinein.

- Drücke Enter, um deine Nachricht zu senden.

2. Interagiere mit dem Chat

Vergleich: LLaMA vs LLaMA 2 Chat

Bei einer kritischen Analyse der beiden Sprachmodelle wird deutlich, dass ihre Trainingsdatensätze sehr unterschiedlich sind. LlaMA verfeinert seine Fähigkeiten durch die Verarbeitung einer Vielzahl von Texten, die von wissenschaftlichen Artikeln bis hin zu Nachrichtenmeldungen reichen, während das Lernen von ChatGPT hauptsächlich auf Internettexten wie Webseiten und Social-Media-Inhalten basiert. Dieser signifikante Kontrast impliziert, dass LlaMA sich möglicherweise durch die Erzeugung von Fach- oder Fachjargon auszeichnet, während ChatGPT möglicherweise besser darin ist, informelle oder Konversationssprache zu erzeugen.

Obwohl diese beiden hochmodernen Sprachmodelle ein enormes Potenzial für die Transformation von Anwendungen zur Verarbeitung natürlicher Sprache haben, weisen sie unterschiedliche Merkmale auf. Die auffälligste Ähnlichkeit zwischen ihnen liegt in ihrer Fähigkeit, bemerkenswert menschenähnliche Sprache zu erzeugen, was für Chatbots, die Erstellung von Inhalten und andere Bereiche, die jenseits unserer Vorstellungskraft liegen, vielversprechend ist.

Zusammenfassend lässt sich sagen, dass trotz der Gemeinsamkeit dieser Kernfähigkeit – einer beeindruckend realistischen sprachlichen Ausgabe – der Unterschied in der Art der Daten, auf denen jedes Modell trainiert, den entscheidenden Unterschied macht, wenn es um die Wahl eines Modells gegenüber einem anderen geht, je nach Ihren spezifischen Anforderungen und Anwendungsfällen.

Kosten & Verfügbarkeit des LLaMA2 Chats

Um ein allumfassendes Modell zu schaffen, werden erhebliche Mittel und unerschütterliches Engagement (ungefähr 25 Millionen US-Dollar für Präferenzdaten zum Marktwert) sowie eine beträchtliche Belegschaft als notwendig erachtet. Trotzdem sind der Code und die Daten, die LLaMA 2 zugrunde liegen, als Open Source erhältlich. Das bedeutet, dass jeder sie kostenlos herunterladen und verwenden kann.

Die beste Alternative zum LLaMA2 Chat: ChatFlash

Bist du auf der Suche nach einem leistungsstarken deutschen Chatbot mit neuster GPT-Technologie oder einer KI Lösung, die dir noch mehr Vielseitigkeit bietet? Dann teste jetzt ChatFlash!

Über Persönlichkeiten ist es möglich, den Output der magischen Feder zielgerichtet zu lenken und zu beeinflussen. Ebenso bietet neuroflash mit Vorlagen bereits optimierte Prompts, welche auf verschiedenste Anwendung angepasst und frei zu verwenden sind.

Eine Persönlichkeit definiert das Folgende:

- Tonfall des Gesprächs

- Rolle (Funktion)

- Persönlichkeit, Marke

- Kontext der erwarteten Antwort

Du kannst aus verschiedenen Persönlichkeiten auswählen. ChatFlash kann beispielsweise als SEO Berater, Social Media Influencer, Journalist oder Schreibcoach antworten. Zusätzlich bieten wir dir die Möglichkeit, eigene Persönlichkeiten hinzuzufügen. So kannst du ChatFlash zum Beispiel an deine Firmenidentität oder deinen persönlichen Schreibstil anpassen. Wir zeigen dir, wie es geht:

Schließlich bietet dir neuroflash eine Vielzahl an weiteren Funktionen, mit denen du Texte noch weiter bearbeiten kannst. Verschiedene Workflows und zusätzliche Features wie eine SEO Analyse, eine Browsererweiterung und ein KI Bildgenerator bieten außerdem einen großen Mehrwert für alle, die Texte für professionelles Zwecke benötigen.

Fazit

Zusammenfassend lässt sich sagen, dass der LLaMA2-Chat zwar mit seinem Open-Source-Modell und der wettbewerbsfähigen Preisgestaltung vielversprechend ist, im Vergleich zu Alternativen wie ChatFlash jedoch letztlich hinter den Erwartungen zurückbleibt. Um das Potenzial eines Chatbots voll auszuschöpfen, sollten Unternehmen und Entwickler alternative Optionen erkunden, die einen robusteren Funktionsumfang und bessere Integrationsmöglichkeiten bieten.