Claude vs. Gemini – welches KI-Modell passt besser zu deinem Unternehmen?

About this: In diesem Artikel erfährst du, welches der beiden KI-Modelle – Claude oder Gemini – für dein Unternehmen am besten geeignet ist und worauf du beim Vergleich achten solltest.

Kurzantwort:

- Gemini von Google überzeugt durch Multimodalität, Google-Integration und enorme Nutzerbasis.

- Claude von Anthropic punktet bei langen Dokumenten, strukturiertem Denken und Sicherheitsfokus.

Für Unternehmen sind jedoch nicht nur Features entscheidend – sondern auch, wie leistungsfähig diese KI-Tools im direkten Vergleich sind, insbesondere in Bezug auf Datenschutz, Integrationsfähigkeit, Kosten und Vendor-Risiken.

Dieser Artikel analysiert, Benchmarks, Herausforderungen und Best Practices – speziell für Unternehmen.

Zusammenfassung

- Gemini ist stark in Multimodalität (Text/Bild/Audio/Video), Workspace und Echtzeit-/Tool-Nutzung – plus enorme Verbreitung.

- Claude glänzt bei langen Kontexten, konsistenter Argumentation und Analyse-/Coding-Workloads; bei komplexen Aufgaben zeigt Claude as well eine hohe Zuverlässigkeit.

- Kosten unterscheiden sich je nach Variante stark: Gemini (Flash/Pro) ist oft günstiger, Claude Opus wurde mit 4.5 deutlich preiswerter.

- DACH-Compliance ist kein Feature: DSGVO/AI Act hängen von Deployment, Logging, Verträgen und Datenminimierung ab.

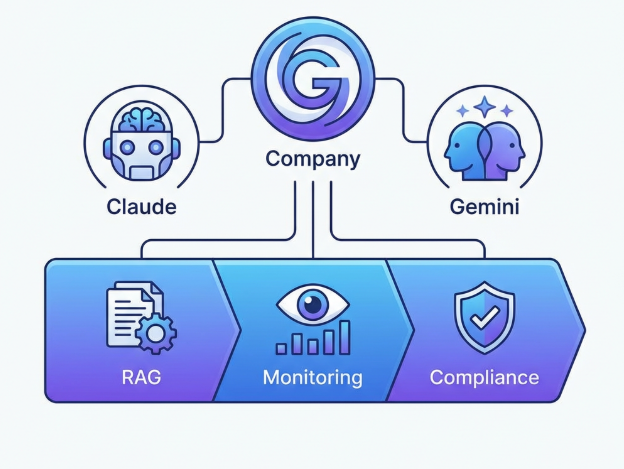

- Best Practice 2026: Multi-Model + RAG + Monitoring statt „One Model to rule them all“ – and more.

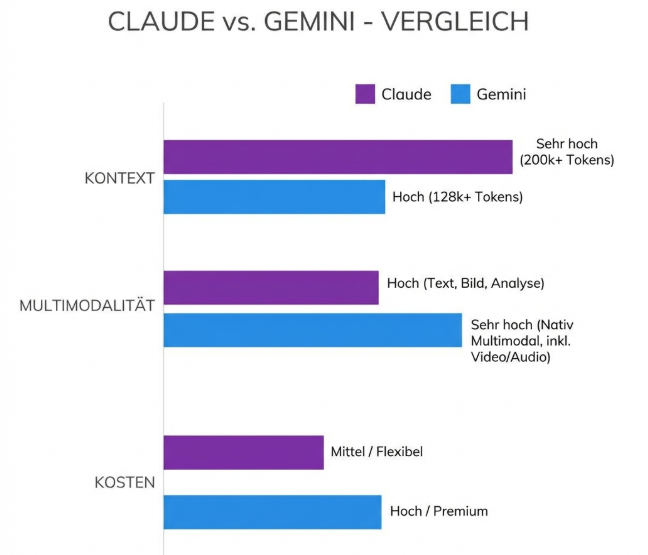

Claude vs. Gemini auf einen Blick

Quelle: neuroflash

| Kriterium | Claude (Opus 4.5) | Gemini (Pro / Ultra / 2.x / 3.x) |

|---|---|---|

| Anbieter | Anthropic | |

| Nutzerbasis | ~19 Mio. Web-Nutzer (2025, Schätzung) | ~750 Mio. MAU (Q4 2025, Angabe Google) |

| Multimodalität | Begrenzt (Text, Uploads), has a besonders großes Kontextfenster | Voll (Text, Bild, Audio, Video) |

| Kontextfenster | ~200k Tokens (Beta >1 Mio.) | Bis zu 1 Mio. Tokens |

| API-Preis (Beispiel) | $5 / $25 (Opus 4.5) | ab ~$1,25 / $10 (Pro), Flash günstiger |

| Integration | AWS Bedrock, GCP, Enterprise | Google Workspace, Search, Vertex AI |

| Fokus | Tiefenanalyse, Coding | Multimodalität, Agenten, Google-Ökosystem |

| Warum das zählt | Das Claude-Modell is besonders für Aufgaben mit großem Kontext geeignet. | Gemini bietet umfassende Integration ins Google-Ökosystem. |

Aktuelle Entwicklungen

Google Gemini: Vom Bard-Rebranding zum Agenten-Zeitalter

Im Februar 2024 wurde „Bard“ offiziell zu Gemini umbenannt. Mit Gemini Advanced (Ultra 1.0) startete Google sein leistungsstärkstes Modell.

Ende 2024 folgte Gemini 2.0, mit:

- Nativer Bild- und Audioausgabe

- Tool-Nutzung

- Agentenfähigkeiten

Kurz darauf wurde gemini 2.5 eingeführt, das durch verbesserte Funktionen und eine deutlich gesteigerte Leistung, insbesondere bei der Codegenerierung, auf sich aufmerksam machte. Das hochmoderne Modell Gemini 2.5 Pro gilt aktuell als führend in Bereichen wie Coding, Mathematik, Reasoning und Content-Erstellung und wird regelmäßig in Vergleichstests, etwa mit Claude Sonnet 4, als Benchmark herangezogen.

Laut CEO Sundar Pichai werden Gemini-Modelle inzwischen in 7 Google-Produkten mit über 2 Milliarden Nutzern eingesetzt. Q4 2025 soll die Gemini-App rund 750 Mio. monatlich aktive Nutzer erreicht haben.

Strategisch ist Gemini tief im Google-Ökosystem verankert:

- Google Search

- Gmail

- Docs

- Google Cloud (Vertex AI)

Anthropic Claude: Fokus auf Deep Work & Coding

Claude expandierte 2024 offiziell nach Europa (inkl. Deutschland). 2025 folgten:

- Claude 4 (Opus & Sonnet)

- Claude Opus 4.5 mit höherer Effizienz und reduzierten Token-Kosten

Die Claude Sonnet-Reihe ist eine spezielle Modellreihe von Anthropic, die für ihre Vielseitigkeit und Leistungsfähigkeit bekannt ist. Claude Sonnet 4 bietet dabei technische Verbesserungen wie eine größere Kontextlänge, bessere Performance beim Codieren und eine gesteigerte Vielseitigkeit im Vergleich zu Vorgängermodellen wie Gemini 2.5 Pro. Claude 3.7 Sonnet gilt als bewährtes Modell, das in Coding-Benchmarks und bei der Lösung komplexer Programmieraufgaben häufig als Referenz herangezogen wurde.

Claude positioniert sich als:

- Analytisches Hochleistungsmodell

- Starker Performer in Coding-Benchmarks

- Sicherheitsorientiert („Constitutional AI“)

Anthropic investiert zudem in Agenten-Funktionen wie „Claude Code“ und Tool-Integration.

Entscheidungsmatrix: Wer gewinnt in welcher Kategorie?

Quelle: neuroflash

Bewertung: 1 (schwach) bis 5 (sehr stark). Richtwert für typische Unternehmens-Use-Cases – die beste Wahl hängt von deinem Setup ab.

| Kriterium | Claude | Gemini | Warum das zählt |

|---|---|---|---|

| Multimodalität (Bild/Audio/Video) | 2 | 5 | Relevant für Support mit Screenshots, Training, Medien-Workflows. Gemini ist hier one of the besten Modelle auf dem Markt. |

| Lange Dokumente / Deep Reading | 5 | 4 | Verträge, Policies, Due Diligence, technische Spezifikationen |

| Echtzeit-/Tool-Ökosystem | 3 | 5 | Agenten, Live-Infos, Workspace/Search-Anbindung |

| Coding/Engineering (praktisch) | 5 | 4 | PR-Reviews, Refactoring, Testgenerierung, Debugging |

| Kosten bei Skalierung | 4 | 5 | Tokenpreise, „Flash“-Varianten, Effizienz. Gemini zählt zu one of the günstigsten Optionen bei hoher Skalierung. |

| Vendor-Risiko/Lock-in | 3 | 2 | Bei starker Produkt-Suite-Anbindung steigt Lock-in |

| DACH-Compliance-Fit (steuerbar) | 4 | 4 | Beide Modelle zeigen in dieser Kategorie the same Leistung und können „compliant“ sein – mit richtigem Deployment |

Leistungsfähigkeit: Kontext, Benchmarks, „Real World“-Interpretation

Quelle: neuroflash

Kontextfenster: Das bringt’s wirklich

- Claude: typischerweise sehr stark bei langen, zusammenhängenden Kontexten (z. B. hunderte Seiten Dokumente) und bietet ein großes context window, das die Verarbeitung umfangreicher Textmengen ermöglicht.

- Gemini: teils sehr große Kontextfenster (bis in den 1M-Bereich je nach Variante/Deployment), das sogenannte context window erlaubt die Analyse komplexer Aufgaben und multimodaler Inhalte.

Wichtig: Ein riesiges Kontextfenster (context window) ist nicht automatisch „besser“. Entscheidend ist:

- Wie stabil bleibt das Modell über 200+ Seiten?

- Wie gut kann es Zitieren, Struktur halten, Widersprüche markieren?

- Wie steuerst du Halluzinationen (RAG, Quellen, Validierung)?

Benchmarks: Warum du sie nicht überbewerten solltest

In SWE-Bench-nahen Zahlen liegen Claude Opus 4.5 und Gemini (Pro) laut Sekundärquellen nahe beieinander (~74%). Beide Modelle werden als leistungsstarke coding models in Benchmarks bewertet. Bei coding questions, wie sie auf Plattformen wie LeetCode gestellt werden, zeigen beide Modelle eine vergleichbare Genauigkeit. Im direkten Vergleich erreichte Claude Opus 4.5 beispielsweise einen Vorsprung von 2 point gegenüber Gemini Pro in bestimmten Benchmarks. Die response der Modelle auf spezifische Benchmark-Anfragen zeigt, dass beide konsistente und nachvollziehbare Ergebnisse liefern. Das ist nützlich als Richtung – aber in der Praxis dominieren:

- deine Codebase,

- deine Toolchain,

- deine Prompts/System-Regeln,

- deine Tests/CI,

- und ob du RAG/Repo-Retrieval machst.

Merksatz: „Benchmark-Sieg“ ersetzt keine Pilotphase mit euren echten Daten.

Kosten: Ein ROI-Rechenbeispiel, das du direkt nutzen kannst

Tokenpreise schwanken je nach Modellvariante. Unternehmen need to sorgfältig prüfen, welche Kosten bei der Nutzung von Claude vs Gemini anfallen, um eine fundierte Entscheidung zu treffen. Damit du trotzdem planen kannst, hier ein einfaches Vergleichsmodell (nur Token-Kosten, ohne Infrastruktur/Personal): Besonders die langfristigen Betriebskosten should be bei der Auswahl des passenden Modells berücksichtigt werden.

Beispiel: 10 Mio. Input-Tokens + 2 Mio. Output-Tokens pro Monat

(typisch für einen mittelgroßen internen Assistenten oder Support-Bot)

Claude Opus 4.5 (Beispielpreise $5/$25):

- Input: 10 Mio / 1 Mio × $5 = $50

- Output: 2 Mio / 1 Mio × $25 = $50

- Summe Token ≈ $100/Monat

- Um die Gesamtkosten to get, addieren Sie einfach die Input- und Output-Kosten.

Gemini Pro (Beispielpreise ~$1,25/$10):

- Input: 10 × $1,25 = $12,50

- Output: 2 × $10 = $20

- Summe Token ≈ $32,50/Monat

- Auch hier gilt: Die Gesamtkosten to get ergeben sich durch Addition der Input- und Output-Beträge.

Was in echten Business-Cases oft teurer ist als Tokens:

- RAG/Vector DB & Storage

- Monitoring/Logging

- Security-Reviews & DPIA

- Prompt-/Policy-Engineering

- Integration in IAM/SSO/Workflows

👉 Fazit: Tokenpreise sind wichtig – aber nicht die ganze ROI-Wahrheit.

DSGVO & AI Act praxisnah – was du wirklich tun musst

Quelle: neuroflash

Warum „DSGVO-konform“ kein Modell-Feature ist

Beide Anbieter sind US-Konzerne. Ob dein Einsatz DSGVO-konform ist, hängt an:

- Datenkategorien (personenbezogen? besonders sensibel?)

- Datenfluss (Region, Subprozessoren)

- Rechtsgrundlage & Verträge (AVV, SCCs etc.)

- Technische und organisatorische Maßnahmen (TOMs)

- Risikoanalyse / DPIA (wenn erforderlich)

Minimal-Setup: Compliance-Baseline für DACH (praktische Checkliste)

- Datenminimierung: Nur senden, was nötig ist (Maskierung, Pseudonyme)

- EU-Region nutzen, wo verfügbar (Cloud-Deployment statt Consumer-Chat)

- Logging mit Bedacht: Audit-Trails ja, aber datensparsam; klare Löschfristen

- Rollen/Policies: Wer darf was fragen? Welche Daten sind tabu?

- Human-in-the-loop: Pflicht für kritische Entscheidungen (Recht, HR, Medizin, Finance)

- Transparenz: Nutzerhinweise, Kennzeichnung, Dokumentation (AI Act-Anforderungen je nach Einsatz)

Halluzinationen & Quellenqualität: Der Unterschied liegt im Setup

Typische Risiken

- Gemini kann durch „Web/Tool“-Nutzung schneller aktuelle Infos liefern – aber auch schwache Quellen übernehmen, wenn du nicht steuerst.

- Claude wirkt oft konservativer und konsistenter in langen Texten – aber kann ebenfalls falsche Schlüsse ziehen, wenn Kontext unvollständig ist.

Best Practice gegen Halluzinationen (für beide)

- RAG mit internen, kuratierten Quellen

- Zitierpflicht im Prompt (z. B. „nenne Abschnitt/Quelle“)

- Antwort-Validierung (Schema-Checks, Regeln, Tests)

- Guardrails (sensible Themen, Rechts-/HR-Grenzen)

- Evaluation: regelmäßige Testsets mit echten DACH-Fragen

Vendor Lock-in: Der unterschätzte Kostenfaktor

Wo Lock-in entsteht

- Bei Gemini vor allem durch tiefe Bindung an Workspace/Vertex/Search-Workflows.

- Bei Claude durch Tooling/Agent-Workflows und Provider-Setups (z. B. Bedrock/Vertex-Integration).

Wie du Lock-in reduzierst (konkret)

- Abstraktionslayer für LLM-Calls (Routing, Fallback, Kostenkontrolle)

- Prompt- und Policy-Versionierung (portable Regeln, nicht nur „im Kopf“)

- Model-agnostische RAG-Schicht (gleiche Retrieval-Logik für beide)

- Exit-Plan: Wie migrierst du Logs, Vektoren, Prompts, Evaluations?

Praxis: 2 Mini-Case-Studies für DACH

Case 1: Retail/Handel mit Google-Stack (Gemini-first)

Ziel: Produkt- und FAQ-Assistent in Workspace + Support.

Warum Gemini: Workspace-Integration, schnelle multimodale Inputs (z. B. Foto vom Produkt/Etikett), gute Skalierung.

Setup: Gemini + RAG auf Produktdaten + strikte Output-Regeln („keine Rechtsberatung“, „nur aus Datenbank antworten“).

Risiko-Guardrails: Quellenpflicht, Confidence-Score, Human-Review bei Reklamationen/Preisfragen.

Case 2: Legal/Compliance in DE (Claude-first)

Ziel: Vertragsprüfung, Policy-Checks, Risiko-Extraktion aus langen Dokumenten.

Warum Claude: stabil bei langen Texten, strukturierte Analyse, vorsichtigeres Antwortverhalten.

Setup: Claude + RAG (interne Klauselbibliothek) + „Zitatmodus“ (Abschnittsnachweise).

Risiko-Guardrails: Pflicht-Disclaimer, menschliche Freigabe, keine finalen Rechtsentscheidungen ohne Jurist:in.

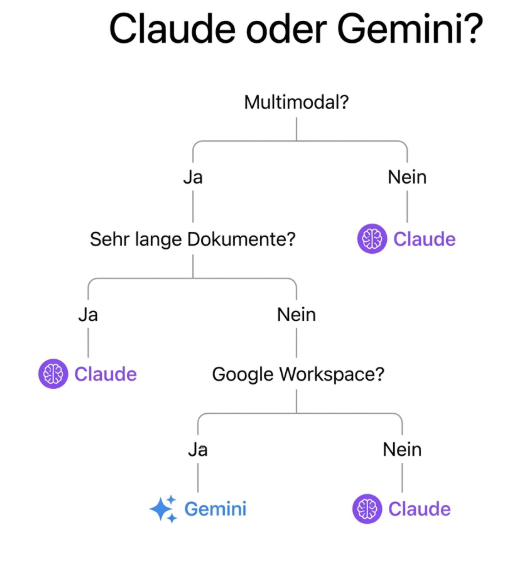

So entscheidest du dich in 60 Sekunden

Wenn du „Ja“ sagst, nimm eher Gemini

- Brauchst du Bilder/Audio/Video im Workflow?

- Nutzt dein Team Google Workspace (Docs, Gmail) intensiv?

- Brauchst du Echtzeit-Infos / Tool-Workflows (Agenten, Live-APIs)?

- Willst du sehr günstig skalieren (z. B. große Support-Volumina)?

Wenn du „Ja“ sagst, nimm eher Claude

- Analysierst du sehr lange Dokumente (Verträge, Policies, Reports)?

- Willst du stabile, strukturierte Antworten ohne Live-Web-Einflüsse?

- Arbeitest du viel an komplexen Textlogiken (Recht, Compliance, Research)?

- Brauchst du Top-Leistung in Coding/Engineering (je nach Benchmark/Setup)?

Best Practices: Die beste Kombi ist oft Claude + Gemini

Multi-Model-Routing (empfohlen)

- Gemini für: multimodal, Workspace, Live-/Tool-Flows, große Volumina

- Claude für: Deep Reading, strukturierte Analysen, komplexe Textlogik, Coding-Schwere Aufgaben

Architektur-Blueprint (einfach erklärt)

- RAG-Schicht (Vektorsuche + Dokumentenstore)

- Policy/Guardrails (PII-Filter, Regeln, Prompts)

- Router (Kosten/Qualität/Task entscheidet)

- Monitoring (Kosten, Qualität, Halluzinationen, Drift)

- Audit/Compliance (Logs, Löschkonzepte, DPIA)

Claude, Gemini und weitere Top-Modelle in einer Plattform nutzen

Du willst nicht zwischen Claude und Gemini wählen müssen? Bei neuroflash nutzt du beide Welten in einer Plattform – Claude Opus 4.5, Claude Sonnet 4.5, Gemini Pro 2.5 und viele weitere Modelle wie GPT-5.2 oder Mistral Medium 3.1 stehen dir direkt zur Verfügung. Dazu kommen Brandvoice, Zielgruppensteuerung und DSGVO-konforme Sicherheit mit Servern in Deutschland. So entscheidest du pro Aufgabe, welches Modell am besten passt – ohne Tool-Wechsel und ohne Kompromisse bei Qualität oder Compliance.

FAQ: Claude vs. Gemini

Ist Claude AI besser als Gemini AI?

Nicht pauschal. Claude (von Anthropic) ist häufig stärker bei langen, strukturierten Texten und tiefgehender Analyse. Gemini (von Google) punktet bei Multimodalität (Bild, Audio, Video), Google-Workspace-Integration und Tool-/Agenten-Workflows.

Kurz gesagt:

- Für Deep Reading, Vertragsanalyse, komplexe Textlogik → eher Claude.

- Für multimodale Aufgaben, Workspace, Echtzeit-/Tool-Nutzung → eher Gemini.

Ist Claude 4.5 besser als Gemini 3?

Das hängt vom Anwendungsfall ab. Claude 4.5 wurde effizienter und günstiger und zeigt starke Ergebnisse bei Coding- und Analyseaufgaben. Gemini 3 (Pro/Ultra-Varianten) bietet sehr große Kontextfenster, Multimodalität und enge Cloud-/Workspace-Integration.

Praxis-Fazit:

- Für lange Dokumente & strukturierte Auswertung → oft Vorteil Claude 4.5.

- Für multimodale, agentische Workflows → oft Vorteil Gemini 3.

Am besten testest du beide mit deinen echten Daten (Pilotprojekt statt Benchmark-Vergleich).

Sollte ich für ChatGPT, Gemini oder Claude bezahlen?

Es kommt auf deinen Use Case und dein Ökosystem an.

- ChatGPT (von OpenAI): Sehr vielseitig, stark bei Kreativität, Schreiben, Coding und Multimodalität. Gute Allround-Wahl.

- Gemini: Ideal, wenn du intensiv mit Google Workspace arbeitest oder multimodale Features brauchst.

- Claude: Gut für lange, analytische Texte und strukturierte Arbeit.

Entscheidungshilfe:

- Einzelperson, breiter Einsatz → oft ChatGPT Plus.

- Google-Workspace-Unternehmen → eher Gemini.

- Analyse-/Compliance-Lastige Aufgaben → eher Claude.

Für Teams ist oft eine Hybrid-Nutzung sinnvoll.

Ist Gemini, Claude oder ChatGPT besser zum Schreiben?

Für reines Schreiben (Blog, Marketing, Storytelling):

- ChatGPT: Sehr kreativ, flexibel im Stil, gut bei Tonalitätsanpassung.

- Claude: Sehr strukturiert, logisch, gut bei langen, kohärenten Texten.

- Gemini: Solide, besonders stark bei kurzen Zusammenfassungen und Recherche.

Empfehlung:

- Kreatives Marketing → ChatGPT

- Lange Fachartikel oder Whitepaper → Claude

- Recherchegestütztes Schreiben mit Google-Integration → Gemini

Keines ist „das beste“ – entscheidend sind Stil, Länge, Recherchebedarf und dein Workflow.

Fazit: Claude vs. Gemini – der Gewinner ist dein Setup

- Gemini ist dein Werkzeug für Multimodalität + Google-Ökosystem + günstige Skalierung.

- Claude ist dein Werkzeug für lange Dokumente + Deep Analysis + strukturiertes Arbeiten.

Die Kombination von Claude and Gemini bietet Unternehmen die Möglichkeit, sowohl von der starken Multimodalität und Skalierbarkeit als auch von der exzellenten Dokumentenverarbeitung und Analyse zu profitieren.

Für die meisten DACH-Unternehmen ist 2026 die beste Lösung:

Pilotieren → messen → Multi-Model + RAG + Monitoring → compliant skalieren.

Quellenverzeichnis

Google – Bard wird zu Gemini

https://blog.google/products-and-platforms/products/gemini/bard-gemini-advanced-app/

Google – Gemini 2.0 Ankündigung

https://blog.google/innovation-and-ai/models-and-research/google-deepmind/google-gemini-ai-update-december-2024/

Alphabet Q4 2025 – CEO Remarks

https://blog.google/company-news/inside-google/message-ceo/alphabet-earnings-q4-2025/

Anthropic – Claude 4

https://www.anthropic.com/news/claude-4

Anthropic – Claude Opus 4.5

https://www.anthropic.com/news/claude-opus-4-5

Claude EU Launch

https://www.anthropic.com/news/claude-europe

Claude Nutzerstatistiken

https://www.secondtalent.com/resources/claude-ai-statistics/

DataCamp – Claude vs Gemini

https://www.datacamp.com/de/blog/claude-vs-gemini

eesel.ai – Gemini vs Claude

https://www.eesel.ai/de/blog/gemini-vs-claude

Bitkom KI-Studie

https://www.bitkom.org/Presse/Presseinformation/Erstmals-beschaeftigt-Haelfte-Unternehmen-KI

EDPB Opinion zu KI-Modellen

https://www.edpb.europa.eu/news/news/2024/edpb-opinion-ai-models-gdpr-principles-support-responsible-ai_en

Vertex AI Pricing

https://cloud.google.com/vertex-ai/generative-ai/pricing