Claude Haiku ist das schnellste und kosteneffizienteste Modell der Claude-3-Familie von Anthropic. Es wurde 2024 gemeinsam mit Sonnet und Opus vorgestellt und ist für High-Volume-Workloads mit niedriger Latenz konzipiert – etwa Klassifikation, Extraktion, Routing und Support-Automatisierung.

Für DACH-Unternehmen entscheidet jedoch nicht nur die Modellleistung. Der Erfolg hängt von Architektur, DSGVO-Konformität, Model-Tiering, Evals und TCO-Kontrolle ab. In diesem Leitfaden bekommst du einen praxisnahen Blueprint – inklusive Rechenbeispiel, Vergleich und Governance-Checkliste.

Zusammenfassung

- Claude Haiku eignet sich für High-Volume-Workloads.

- Model Tiering senkt Kosten signifikant.

- DSGVO-Compliance ist entscheidend.

- Eigene Evals sind Pflicht.

- Architektur schlägt Modellwahl.

Was ist Claude Haiku – und wann lohnt es sich?

Quelle: neuroflash

Claude Haiku ist innerhalb der Claude-3-Generation als „Fast & Efficient“-Modell positioniert.

Typische Stärken

- Sehr schnelle Antwortzeiten

- Geringere Tokenkosten

- Gut für strukturierte Aufgaben

- Hohe Skalierbarkeit bei Volumen

Nicht ideal für

- Komplexes juristisches Reasoning

- Tiefgehende Strategieanalyse

- Mehrstufige Argumentationsketten

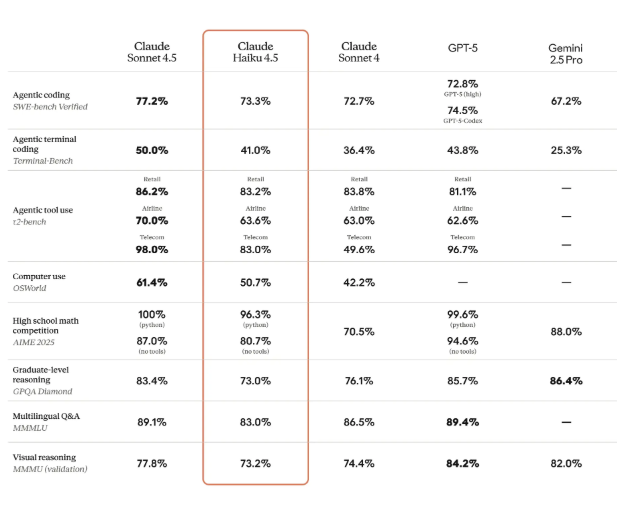

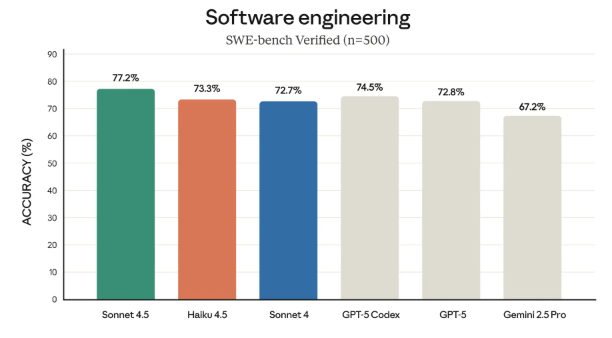

Markttrend 2024–2025: Small-Model-Economics

Quelle: Anthropic

Der KI-Markt verschiebt sich klar:

Weg von „maximal intelligent“

Hin zu „ausreichend gut, extrem günstig, extrem schnell“

In Support-, Backoffice- und RAG-Systemen können 70–90 % der Anfragen mit einem Small Model verarbeitet werden – wenn Routing sauber implementiert ist.

Das macht Claude Haiku zu einem strategischen Default-Layer in Enterprise-Architekturen.

Claude Haiku vs. Sonnet vs. Opus – Vergleich für Entscheider

| Kriterium | Claude Haiku | Claude Sonnet | Claude Opus |

|---|---|---|---|

| Rolle | Speed & Cost | Balanced | Maximum Intelligence |

| Typische Use Cases | Klassifikation, Routing | Analyse, Content | Komplexes Reasoning |

| Kostenstruktur | Niedrig | Mittel | Hoch |

| Skalierung | Sehr hoch | Hoch | Selektiv |

Quelle: Anthropic

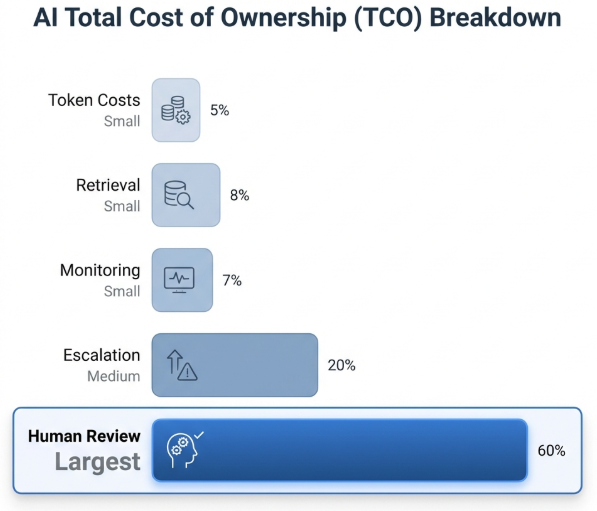

TCO-Rechenbeispiel: Wann spart Claude Haiku wirklich Geld?

Viele Unternehmen unterschätzen die Gesamtkosten.

Beispielrechnung (vereinfachtes Szenario)

Annahmen:

- 1 Mio. Requests/Monat

- 800 Tokens pro Anfrage

- 10 % Eskalation

- 5 % Human Review

- 2 Minuten Review-Zeit

Relevante Kostenblöcke

- Tokenkosten

- Retrievalkosten (RAG)

- Monitoring

- Human Review

- Eskalationskosten

Oft zeigt sich:

Human Review ist teurer als Tokenkosten.

Der strategische Hebel liegt in Confidence-Routing und sauberem Model Tiering.

DSGVO & Governance im DACH-Kontext

Rechtsgrundlage ist die Datenschutz-Grundverordnung.

Kritische Punkte

- Zweckbindung

- Datenminimierung

- AV-Verträge

- Logging-Transparenz

- Drittlandtransfer-Prüfung

Im Kontext internationaler Datenübermittlung ist die Entscheidung des Gerichtshof der Europäischen Union (Schrems II) relevant.

DSGVO-Blueprint für Claude Haiku

PII-Redaktion vor dem Modell

- Entferne personenbezogene Daten

- Pseudonymisiere Identifikatoren

Logging-Minimierung

- Keine Klartext-Prompts in Observability-Tools

- Separate Audit-Trails

RAG-Whitelisting

- Nur freigegebene Dokumenten-Collections

- Quellenangaben erzwingen

Human-in-the-Loop bei Risiko

- HR

- Kreditentscheidungen

- Versicherung

- Medizin

Referenzarchitektur für Enterprise

Empfohlener Ablauf

- Input (Ticket, Dokument, Mail)

- PII-Filter

- Klassifikation

- RAG

- Claude Haiku (Default)

- Confidence-Scoring

- Eskalation

- Policy-Postprocessing

- Monitoring & Evals

Umsetzung und Implementierung: Von der Pilotierung zum Rollout

Quelle: neuroflash

Die erfolgreiche Einführung von KI-Modellen wie Claude Haiku 4.5 beginnt mit einer klaren Zieldefinition und einer strukturierten Planung. Unternehmen sollten zunächst ihre spezifischen Anforderungen analysieren, um das passende Modell aus der Claude-Familie auszuwählen. Gerade Claude Haiku 4.5 überzeugt durch seine Effizienz und Geschwindigkeit und eignet sich ideal für Anwendungen, bei denen niedrige Latenz und hohe Skalierbarkeit gefragt sind.

Anthropic stellt mit der Claude API und der Claude Code Plattform leistungsstarke Werkzeuge bereit, um die Integration von Haiku 4.5 in bestehende Systeme zu erleichtern. Über die API lässt sich das Modell flexibel in verschiedene Anwendungen einbinden – von internen Tools bis hin zu kundenorientierten Applikationen. Die Claude Code Umgebung ermöglicht es Entwicklern, KI-basierte Lösungen schnell zu prototypisieren und produktiv zu setzen.

Ein bewährter Ansatz ist die Pilotierung: Unternehmen testen Claude Haiku 4.5 zunächst in einem kontrollierten Rahmen, etwa mit ausgewählten Datensätzen oder in einem bestimmten Geschäftsbereich. So lassen sich die Leistung und Zuverlässigkeit des Modells realitätsnah evaluieren, bevor es in den flächendeckenden Einsatz geht. Typische Pilotprojekte nutzen die API, um Workflows wie Klassifikation, Extraktion oder automatisierte Antworten zu simulieren und zu optimieren.

Nach einer erfolgreichen Pilotphase folgt der schrittweise Rollout. Hierbei ist es entscheidend, alle relevanten Teams durch gezielte Schulungen und eine umfassende Dokumentation mit der neuen KI-Lösung vertraut zu machen. Ein kontinuierliches Monitoring der Modellleistung und der Nutzung ist unerlässlich, um frühzeitig Optimierungspotenziale zu erkennen und die Qualität der Anwendungen langfristig zu sichern. So wird Claude Haiku 4.5 zum zuverlässigen Baustein für innovative KI-Anwendungen im Unternehmen.

Evals statt Marketing-Benchmarks

Öffentliche Benchmarks reichen nicht.

Eigene Eval-Matrix aufbauen

- Deutsche Rechtstexte

- Fachjargon

- Halluzinationsrate

- PII-Leakage-Tests

- Prompt-Injection-Szenarien

- Tool-Use-Fehlerrate

Ohne Regression-Tests ist produktiver LLM-Betrieb riskant.

Konkrete Use-Cases für Claude Haiku

IT-Helpdesk

- Ticket-Zusammenfassungen

- Priorisierung

- Standardantworten

Vertragsprüfung

- Kündigungsfristen erkennen

- Risiko-Level klassifizieren

- Klauseln extrahieren

Supply-Chain

- Störungsmeldungen strukturieren

- Wartungsberichte clustern

Zukunft von KI-Modellen: Perspektiven für DACH-Unternehmen

Quelle: neuroflash

Die nächsten Jahre versprechen eine rasante Weiterentwicklung im Bereich der KI-Modelle – und DACH-Unternehmen stehen dabei im Zentrum der Innovation. Mit Lösungen wie Claude Haiku 4.5 und den fortschrittlichen Modellen der Claude-Familie, etwa Claude Sonnet 4.5, eröffnen sich neue Möglichkeiten für die Automatisierung und Optimierung von Geschäftsprozessen.

Insbesondere in Echtzeit-Anwendungen wie Chat-Assistenten, Kundenservice oder Support-Automatisierung spielt die hohe Leistung und Flexibilität von Haiku 4.5 ihre Stärken aus. Unternehmen profitieren von schnellen Reaktionszeiten, präzisen Ergebnissen und einer nahtlosen Integration in bestehende Systeme. Die Nutzung der Claude API ermöglicht es, KI-Modelle wie Haiku und Sonnet flexibel in verschiedene Anwendungen einzubinden und so individuelle Anforderungen optimal abzudecken.

Die Cloud-Infrastruktur von Anbietern wie Amazon und Google bietet dabei die notwendige Skalierbarkeit und Sicherheit, um auch große Datenmengen und hohe Nutzerzahlen zuverlässig zu bewältigen. Frontier-Modelle wie Claude Sonnet 4.5 setzen neue Maßstäbe in Sachen Intelligenz und Anwendungsbreite und ermöglichen es Unternehmen, innovative Produkte und Services zu entwickeln.

Für DACH-Unternehmen bedeutet das: Wer frühzeitig auf leistungsfähige KI-Modelle wie Claude Haiku 4.5 setzt, kann seine Wettbewerbsfähigkeit stärken, neue Märkte erschließen und die Kundenzufriedenheit nachhaltig steigern. Gleichzeitig ist es wichtig, die Belegschaft auf den Umgang mit KI vorzubereiten und ethische sowie soziale Aspekte im Blick zu behalten. So wird der Einsatz von KI nicht nur zum Effizienztreiber, sondern auch zum Motor für nachhaltige Innovation und Wachstum.

Häufige Fehler bei der Einführung

- „Einfach API anschließen“

- Kein Logging-Konzept

- Keine Datenklassifizierung

- Kein Eskalationsmodell

- Kein Kostenmonitoring

Claude Haiku und weitere KI-Modelle in einer Plattform nutzen

Du willst Claude Haiku für schnelle, kosteneffiziente Content-Aufgaben einsetzen? Bei neuroflash nutzt du Claude Haiku 4.5 direkt in einer Plattform, die auf professionelle Content-Erstellung ausgerichtet ist – mit Brandvoice, Zielgruppensteuerung und DSGVO-konformer Sicherheit. Und weil manche Aufgaben mehr Power brauchen, stehen dir neben Claude Haiku auch Claude Sonnet 4.5, Claude Opus 4.5, GPT-5.2, Gemini Pro 2.5 und viele weitere Modelle zur Verfügung. So wählst du für jede Aufgabe das passende Modell – schnell, flexibel und an einem Ort.

FAQ zu Claude Haiku

1. Was ist Claude Haiku?

Claude Haiku ist das schnelle und kosteneffiziente Modell innerhalb der Claude-3-Familie von Anthropic.

Es ist für Aufgaben optimiert, bei denen geringe Latenz und niedrige Kosten pro Anfrage wichtiger sind als maximales Reasoning.

Typische Einsatzbereiche:

- Klassifikation von Tickets

- Datenextraktion

- Zusammenfassungen

- Routing-Entscheidungen

- Standard-Chat-Automationen

Kurz gesagt:

Claude Haiku ist das „Small Model“ für hohe Anfragevolumina.

Was ist besser: Claude Haiku oder Claude Sonnet?

Das hängt vom Use Case ab.

| Vergleichspunkt | Claude Haiku | Claude Sonnet |

|---|---|---|

| Geschwindigkeit | Sehr schnell | Schnell |

| Kosten | Niedriger | Höher |

| Komplexes Reasoning | Begrenzt | Deutlich stärker |

| Typische Nutzung | Standardfälle | Anspruchsvollere Aufgaben |

Entscheidungsregel:

- Haiku ist besser, wenn du hohe Volumina, strukturierte Aufgaben und Kosteneffizienz brauchst.

- Sonnet ist besser, wenn du komplexe Analysen, strategisches Denken oder anspruchsvolle Textarbeit benötigst.

In Enterprise-Architekturen wird oft beides kombiniert (Model Tiering).

Ist Claude 3.5 Haiku kostenlos?

Nein, Claude 3.5 Haiku ist nicht grundsätzlich kostenlos.

Die Nutzung erfolgt in der Regel über:

- API-Zugriff (tokenbasiertes Preismodell)

- Plattform-Integrationen

- Enterprise-Verträge

Preise können sich ändern und sollten direkt bei Anthropic geprüft werden:

https://www.anthropic.com/pricing

Teilweise gibt es limitierte Nutzungsmöglichkeiten in bestimmten Interfaces oder Testumgebungen, aber für produktiven Einsatz fallen Kosten an.

Warum nutzt Claude Code 3.5 Haiku?

Claude Code nutzt häufig Claude 3.5 Haiku, weil:

- Code-Vorschläge schnell generiert werden müssen

- Hohe Interaktionsfrequenz entsteht

- Latenz wichtiger ist als maximales Deep Reasoning

- Kosten pro Anfrage kontrolliert bleiben sollen

Beim Programmieren sind viele Anfragen:

- syntaktische Korrekturen

- Refactoring

- kleinere Funktionsvorschläge

Für solche Aufgaben ist ein schnelles Small Model effizienter als ein großes High-Reasoning-Modell.

Größere Modelle werden eher bei:

- komplexer Architekturplanung

- Debugging mehrerer Systemebenen

- tiefgehender Analyse

eingesetzt.

Fazit: Claude Haiku als strategischer Infrastruktur-Baustein

Claude Haiku ist kein Selbstläufer.

Der Wettbewerbsvorteil entsteht durch:

- saubere Architektur

- messbare Qualität

- kontrolliertes Routing

- Governance-Transparenz

Richtig implementiert wird Claude Haiku zum Kosten- und Skalierungshebel im Enterprise-Umfeld.