Chatbots sind zu einem wesentlichen Bestandteil des Kundendienstes und der Kommunikation geworden, aber sind die Unterhaltungen mit diesen Bots öffentlich oder privat? In diesem Artikel gehen wir auf die verschiedenen Bedenken und Fragen rund um den Datenschutz bei Chatbots ein und bieten nützliche Tipps für Nutzer und Unternehmen, damit ihre Daten sicher bleiben.

Da Chatbots zunehmend zum ersten Kontaktpunkt zwischen Nutzern und Unternehmen werden, ist es nicht verwunderlich, dass die Sorge um den Datenschutz zunimmt. Das reibungslose Funktionieren von KI-gesteuerten Chatbots beruht auf Dateneinspeisungen, um kontextbezogene Antworten zu erstellen. Daher ist die Verwaltung und Speicherung dieser Daten von größter Bedeutung, um einen möglichen Missbrauch oder unberechtigten Zugriff zu verhindern. Als Nutzer ist es wichtig, die Auswirkungen des Chats mit KI-basierten Diensten auf die Privatsphäre zu verstehen, insbesondere angesichts der zunehmenden Bedenken hinsichtlich des Missbrauchs persönlicher Daten.

AI Chatbots wie ChatGPT und Datenschutz

Da sich KI-gesteuerte Chatbots immer weiter entwickeln und in verschiedenen Branchen Anwendung finden, stellen sich viele Menschen die Frage nach dem Datenschutz und der Sicherheit ihrer Unterhaltungen. Dies wirft wichtige Fragen auf, z. B.: Kann jeder auf Chatbot-Unterhaltungen zugreifen? Wie sicher sind Chatbot-Plattformen?

Chatbot-Plattformen wie ChatGPT haben Sicherheitsmaßnahmen eingeführt, um die Privatsphäre der Nutzer zu schützen. Dennoch können andere Plattformen immer noch Sicherheitslücken aufweisen, die ein Risiko für die Nutzerdaten darstellen. Um die Feinheiten des Chatbot-Datenschutzes zu entschlüsseln, ist die Bewertung der Richtlinien und Sicherheitsmerkmale der jeweiligen Plattformen entscheidend. Klare und präzise Richtlinien zur Datennutzung, -speicherung und -entsorgung können dazu beitragen, Bedenken hinsichtlich des Datenschutzes zu zerstreuen und gleichzeitig der Öffentlichkeit zu ermöglichen, fundierte Entscheidungen zu treffen, wenn sie Chatbot-Dienste in Anspruch nimmt.

Welche Bedenken gibt es in Bezug auf den Datenschutz bei Chatbots?

Zu den datenschutzrechtlichen Bedenken im Zusammenhang mit Chatbots gehören die Datenspeicherung und der Datenzugriff, die Datensicherheit und die Gefahr des Missbrauchs sensibler Informationen. In manchen Fällen gehen die Nutzer davon aus, dass ihre Chats privat sind, nur um später festzustellen, dass ihre Unterhaltungen von anderen eingesehen werden können. Es hat Fälle gegeben, in denen sensible Informationen versehentlich durchgesickert sind oder auf die ohne Zustimmung zugegriffen wurde, was zu möglichen ethischen und rechtlichen Konsequenzen geführt hat. Das Niveau des Datenschutzes und der Sicherheit, das von Chatbot-Plattformen angeboten wird, variiert beträchtlich, daher ist es wichtig, eine seriöse Plattform für Ihre Chatbot-Anforderungen auszuwählen.

Speichert ChatGPT das Benutzerdatum?

Es ist wichtig zu beachten, dass OpenAI und die Anwendungen oder Plattformen, die ChatGPT nutzen, Nutzerdaten und Eingaben für verschiedene Zwecke speichern können, z. B. zur Verbesserung der Nutzererfahrung oder zur Bereitstellung personalisierter Empfehlungen. Es wird immer empfohlen, die Datenschutzrichtlinien der jeweiligen Anwendung oder Plattform zu prüfen, um zu verstehen, wie die Nutzerdaten behandelt werden. Wenn Sie Bedenken haben, wie Ihre Daten verwendet oder gespeichert werden, sollten Sie sich direkt an den Anbieter der Anwendung oder Plattform wenden.

Gibt es Bedenken hinsichtlich des Datenschutzes bei ChatGPT?

Wie jedes andere KI-Modell hat auch ChatGPT das Potenzial, die Privatsphäre zu bedrohen, wenn es nicht verantwortungsbewusst eingesetzt wird. Es liegt jedoch in der Verantwortung der Entwickler und Nutzer des Modells, den Schutz der Privatsphäre zu gewährleisten. ChatGPT selbst ist nicht dazu gedacht, persönliche Informationen zu sammeln oder zu speichern, aber es kann möglicherweise persönliche Informationen preisgeben, wenn es Zugriff auf sensible Daten erhält. Wenn ein Nutzer zum Beispiel persönliche Informationen in eine Eingabeaufforderung eingibt, kann ChatGPT diese Informationen verwenden, um eine Antwort zu generieren. Um Datenschutzbedenken zu entkräften, sollten Entwickler und Benutzer sicherstellen, dass keine sensiblen Daten in Eingabeaufforderungen eingegeben werden und dass alle eingegebenen Daten ordnungsgemäß verschlüsselt und geschützt werden. Darüber hinaus sollten die Entwickler Datenschutz- und Sicherheitsmaßnahmen wie Datenanonymisierung, Zugriffskontrollen und sichere Speicherung zum Schutz der Benutzerdaten implementieren.

Woran erkennen Sie, dass Sie es mit einem Chatbot zu tun haben?

Die Feststellung, ob Sie mit einem Chatbot interagieren, kann schwierig sein, da hochentwickelte KI-Chatbots in ihren Antworten dem Menschen sehr ähnlich sind. Einige Anzeichen dafür, dass Sie möglicherweise mit einem Chatbot sprechen, sind generische oder sich wiederholende Antworten, Antworten, die in keinem Zusammenhang mit Ihren Fragen stehen, die Unfähigkeit, komplexe Anfragen zu bearbeiten, und eine konsistente, nahezu perfekte Grammatik und Rechtschreibung. Geschickt entwickelte Chatbots wie ChatGPT können manchmal nicht von echten Menschen unterschieden werden, aber das Erkennen von Chatbots im Allgemeinen beruht oft auf dem Erkennen von Mustern in ihrer Kommunikation.

Die meisten Chatbots sind zwar benutzerfreundlich und sollen das Nutzererlebnis verbessern, doch kann es wichtig sein, zu erkennen, ob Sie mit einem Chatbot interagieren, wenn Sie Bedenken hinsichtlich des Datenschutzes oder der Datensicherheit haben. Eine Möglichkeit, sich zu vergewissern, ob Sie mit einem Chatbot kommunizieren, besteht darin, ihm einfache Fragen zu seiner Natur oder zu kontextbezogenen Informationen zu stellen, die ein Mensch schnell verstehen würde. Ein Chatbot kann sich schwer tun, relevante Antworten zu geben, oder Ungereimtheiten bei der Beantwortung aufweisen, was seine künstliche Natur offenbart. Einige Plattformen und Websites weisen auch auf die Verwendung von Chatbots hin, was Ihnen helfen kann festzustellen, ob Sie mit einem Chatbot sprechen.

Wie groß ist das rechtliche Risiko für Chatbots?

Zu den rechtlichen Risiken im Zusammenhang mit Chatbots können Verstöße gegen Gesetze zum Schutz der Privatsphäre und des Datenschutzes gehören, wie z. B. die GDPR in der Europäischen Union. Weitere potenzielle Risiken sind die unbefugte Offenlegung sensibler Informationen oder die Verleumdung durch unangemessene Antworten, die von Chatbots generiert werden. Unternehmen, die Chatbots einsetzen, müssen sicherstellen, dass sie die geltenden Gesetze und Vorschriften einhalten, was häufig bedeutet, dass sie die Datenspeicherungs- und Datenschutzrichtlinien der von ihnen verwendeten Chatbot-Plattformen kennen.

Abgesehen von den primären rechtlichen Risiken besteht ein wachsender Bedarf, sicherzustellen, dass Chatbots ethisch und verantwortungsbewusst funktionieren. Dazu gehören die Gewährleistung von Transparenz bei der Datenerhebung und -verarbeitung, die faire Nutzung von Daten und Algorithmen sowie die Gewährleistung eines gleichberechtigten Zugangs zu Dienstleistungen. Die Einhaltung ethischer Richtlinien kann Unternehmen dabei helfen, potenzielle rechtliche Risiken zu minimieren, das Vertrauen der Verbraucher zu fördern und die breitere Einführung von Chatbot-Technologien zu erleichtern. Außerdem müssen Unternehmen unbedingt in die laufende Überwachung, regelmäßige Audits und Mitarbeiterschulungen investieren, um sicherzustellen, dass Chatbots mit den Vorschriften und ethischen Standards konform bleiben.

Was können Chatbots nicht tun?

Trotz ihrer zunehmenden Ausgereiftheit haben Chatbots immer noch ihre Grenzen. Sie können menschliche Emotionen noch nicht vollständig verstehen oder wiedergeben, keine wirklich einfühlsamen Gespräche führen oder Lösungen für abstrakte oder hochkomplexe Probleme anbieten. Chatbots haben auch Schwierigkeiten, mit Sarkasmus, Ironie und Humor effektiv umzugehen. Außerdem sind sie an die Grenzen ihrer Programmierung und der Daten, auf denen sie trainiert wurden, gebunden, was bedeutet, dass sie möglicherweise nicht jede Frage, die ihnen gestellt wird, genau beantworten oder personalisierte Unterstützung bieten können. Generell werden Chatbots immer besser, aber sie haben noch einen weiten Weg vor sich, bis sie in allen Aspekten der Kommunikation wirklich mit menschlichen Fähigkeiten konkurrieren können.

Die Einschränkungen von Chatbots haben verschiedene Auswirkungen auf die Privatsphäre der Nutzer. So könnten Chatbots beispielsweise versehentlich sensible Nutzerdaten falsch interpretieren oder nicht erkennen, wenn ein Nutzer Unbehagen ausdrückt. Dies könnte zu unbeabsichtigten Datenschutzverletzungen oder unangenehmen Erfahrungen führen. Für Entwickler ist es entscheidend, sich dieser Einschränkungen bewusst zu sein und sich darauf zu konzentrieren, die Chatbot-Funktionen im Laufe der Zeit zu verbessern, um potenzielle Risiken zu minimieren. Darüber hinaus sollten Unternehmen, die Chatbot-Technologie einsetzen, Transparenz über den Umfang und die Grenzen des Dienstes bieten, damit die Nutzer fundierte Entscheidungen darüber treffen können, welche Arten von Gesprächen und Daten sie teilen möchten.

Nützliche Tipps

- Entscheiden Sie sich für eine seriöse Chatbot-Plattform, die einen starken Fokus auf Sicherheit und Datenschutz legt.

- Prüfen Sie die Datenschutzrichtlinien jedes Chatbot-Anbieters, um sicherzustellen, dass sie mit Ihren Datenschutzanforderungen übereinstimmen.

- Bringen Sie Ihrem Chatbot bei, die Erfassung von personenbezogenen Daten (PII) nach Möglichkeit zu vermeiden.

- Verschlüsseln und schützen Sie gespeicherte Daten, um unbefugten Zugriff zu verhindern.

- Aktualisieren und prüfen Sie Ihr Chatbot-System regelmäßig, um sicherzustellen, dass es mit den Datenschutzbestimmungen konform ist.

Die Umsetzung dieser Tipps kann Unternehmen helfen, die mit der Nutzung von Chatbots verbundenen Datenschutzrisiken zu minimieren und sicherzustellen, dass sie ihren Nutzern einen sicheren und vertrauenswürdigen Service bieten. Transparenz und kontinuierliche Verbesserung sind entscheidende Komponenten eines wirksamen Chatbot-Datenschutzmanagements. Indem sie sich auf die Sicherheit der Nutzer konzentrieren, können Unternehmen Vertrauen aufbauen und ein stärkeres Engagement der Nutzer mit Chatbot-gestützten Diensten fördern.

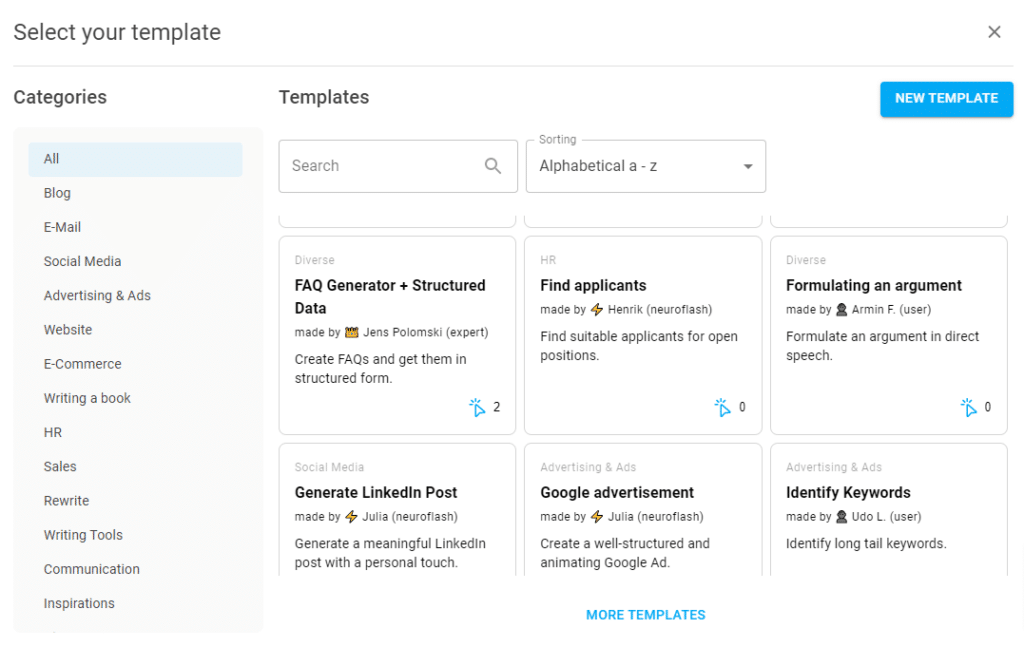

neuroflash als der Chatbot, dem Sie vertrauen können

neuroflash bietet eine leistungsstarke ChatGPT-Alternative mit vielfältigen Funktionen, intuitiven Arbeitsabläufen und reibungsloser Integration in bestehende Anwendungen. Im Gegensatz zu ChatGPT speichert neuroflash keine Benutzerdaten oder Unterhaltungen, sondern bietet stattdessen Gemeinschaftsaufforderungen und -vorlagen, die der Benutzer nach eigenem Ermessen freigeben kann. Diese nützlichen und effizienten Prompts für die KI können von den Neuroflash-Nutzern ausgetauscht und bewertet werden, um sich gegenseitig bei der Erzeugung der bestmöglichen Ergebnisse zu unterstützen.

Zur Gewährleistung von Datenschutz und Sicherheit für Ihr Chatbot-System, melden Sie sich bei neuroflash für eine zuverlässige und sichere Lösung.

Schlussfolgerung

Zusammenfassend lässt sich sagen, dass Chatbot-Unterhaltungen je nach Plattform oder Anwendung entweder öffentlich oder privat sein können. Für Nutzer und Unternehmen ist es von entscheidender Bedeutung, die potenziellen Datenschutzbedenken im Zusammenhang mit der Nutzung von Chatbots zu verstehen und die notwendigen Vorkehrungen zum Schutz ihrer sensiblen Daten zu treffen. Da sich die KI- und Chatbot-Technologien weiter entwickeln, ist es für die Branche von entscheidender Bedeutung, sich weiterhin stark auf Sicherheit und Datenschutz zu konzentrieren, um das Vertrauen der Nutzer zu gewährleisten.