Die Landschaft der künstlichen Intelligenz entwickelt sich schnell, mit neuen Akteuren und bahnbrechenden Technologien, die in rasantem Tempo auftauchen. Während OpenAI lange eine prominente Position mit seinen bahnbrechenden Modellen innehatte, ist ein neuer Herausforderer auf den Plan getreten: DeepSeek. Dieses chinesische KI-Start-up sorgt mit seinem Open-Source-Ansatz und schnellen Fortschritten für Aufsehen und schafft eine Dynamik, die die Zukunft der KI neu gestaltet.

DeepSeek: Der Open-Source-Herausforderer

DeepSeek ist ein chinesisches KI-Unternehmen, das schnell Aufmerksamkeit erregt hat, dank der Entwicklung leistungsstarker, Open-Source-basierter großer Sprachmodelle (LLMs). Es wurde 2023 von Liang Wenfeng gegründet und wird vom chinesischen Hedgefonds High-Flyer finanziert. Sie haben mehrere Modelle veröffentlicht, wobei DeepSeek-R1 und DeepSeek-V3 zu den bekanntesten gehören.

DeepSeek, 2023 gegründet, ist ein chinesisches KI-Unternehmen, das schnell zu einer wichtigen Größe geworden ist. Im Gegensatz zum proprietären Modell von OpenAI konzentriert sich DeepSeek auf Open-Source-große Sprachmodelle (LLMs). Das bedeutet, dass ihr Code für jeden frei verfügbar ist, um ihn zu nutzen, zu modifizieren und daraus zu lernen. Dies ist ein wesentlicher Unterschied und hat DeepSeek geholfen, in der KI-Community erheblichen Zuspruch zu finden.

Ihr Fokus liegt jedoch nicht nur auf Zugänglichkeit. DeepSeek hat beeindruckende Ergebnisse bei der Entwicklung leistungsstarker Modelle erzielt, insbesondere bei fortgeschrittenen Aufgaben wie mathematischer Problemlösung und logischer Schlussfolgerung. Sie haben auch gezeigt, dass sie ihre Modelle mit beeindruckender Effizienz trainieren können, indem sie weniger leistungsstarke Hardware und deutlich geringere Kosten als die Wettbewerber nutzen. Dies verändert die Erzählung darüber, wer leistungsstarke KI entwickeln kann und wie dies getan werden kann.

Schlüsselmerkmale von DeepSeek:

- Open-Source-Ansatz: Die Modelle von DeepSeek sind hauptsächlich Open-Source, was bedeutet, dass ihr Code frei verfügbar ist, um genutzt, modifiziert und eingesehen zu werden, oft unter der MIT-Lizenz. Dies ermöglicht es Forschern und Entwicklern, auf ihrer Arbeit aufzubauen. Dies unterscheidet sich stark von vielen US-Unternehmen wie OpenAI, die einen eher Closed-Source-Ansatz verfolgen.

- Kostengünstiges Training: DeepSeek hat die Fähigkeit gezeigt, hohe Leistung mit deutlich weniger Ressourcen als die Wettbewerber zu erzielen. Berichten zufolge haben sie das DeepSeek-R1-Modell mit weniger leistungsstarken Chips und zu einem Bruchteil der Kosten vergleichbarer Modelle von Unternehmen wie OpenAI trainiert. Dies deutet darauf hin, dass sie sehr effizient mit ihren Ressourcen umgehen.

- Schlussfolgerungsfähigkeiten: Die Modelle von DeepSeek, insbesondere das R1-Modell, wurden mit einem Fokus auf fortgeschrittene Schlussfolgerungsaufgaben wie mathematische Problemlösungen und logische Inferenz entwickelt. Dies hebt sie von typischen Sprachmodellen ab.

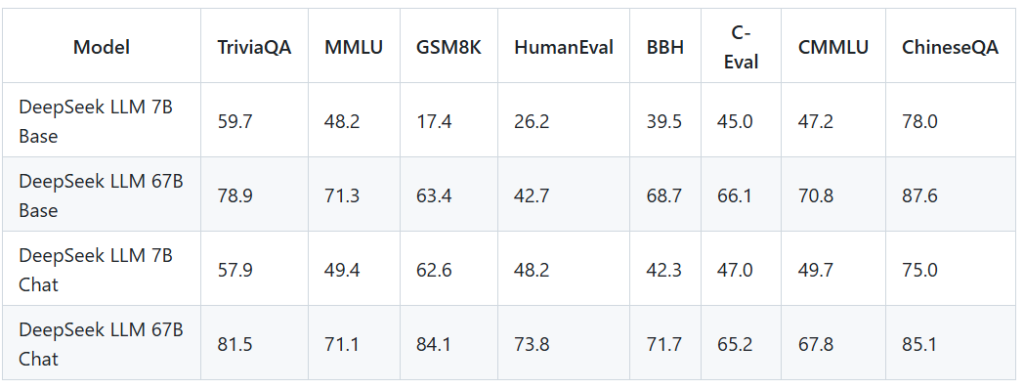

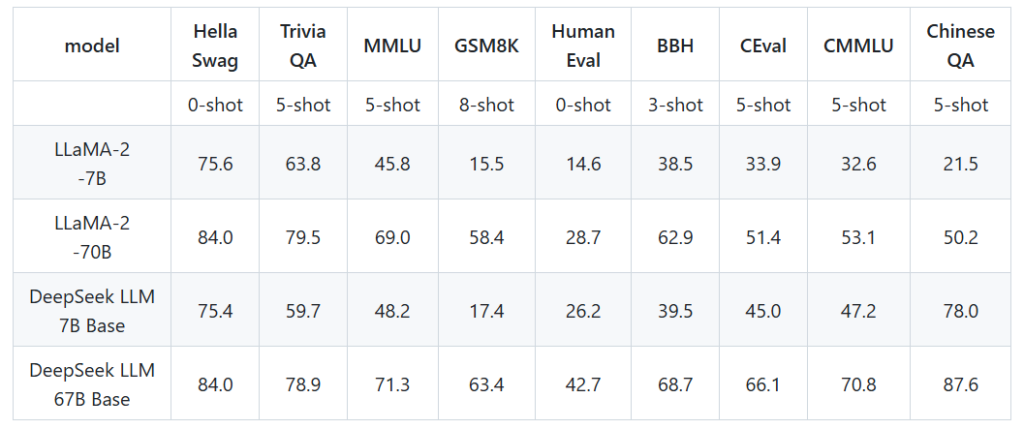

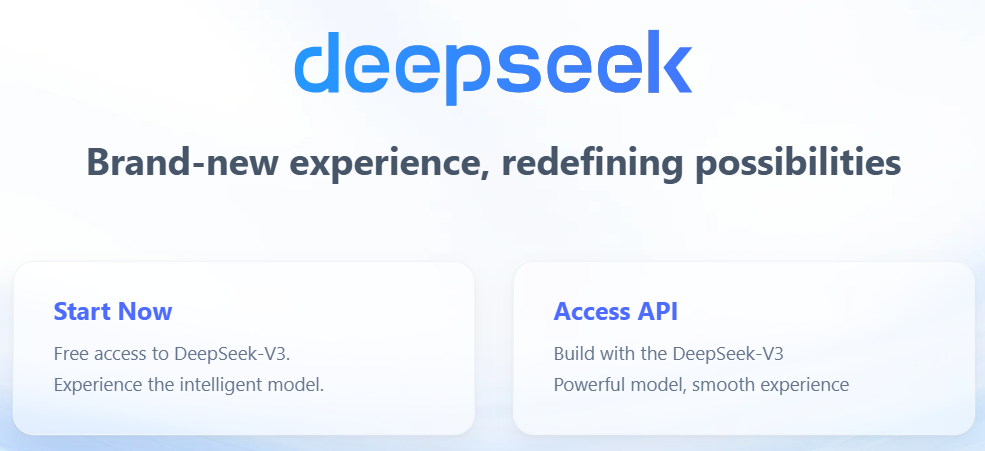

- Leistung: Die Modelle von DeepSeek erreichen Leistungsniveaus, die mit den führenden Modellen von OpenAI und Google bei bestimmten Benchmarks konkurrieren oder diese übertreffen. Mehr dazu hier.

- Schnelles Wachstum: Das Unternehmen hat schnell an Bedeutung gewonnen, mit seinen Apps, die die Spitze der App-Store-Charts erreichten und bedeutende Diskussionen in der Tech-Welt auslösten.

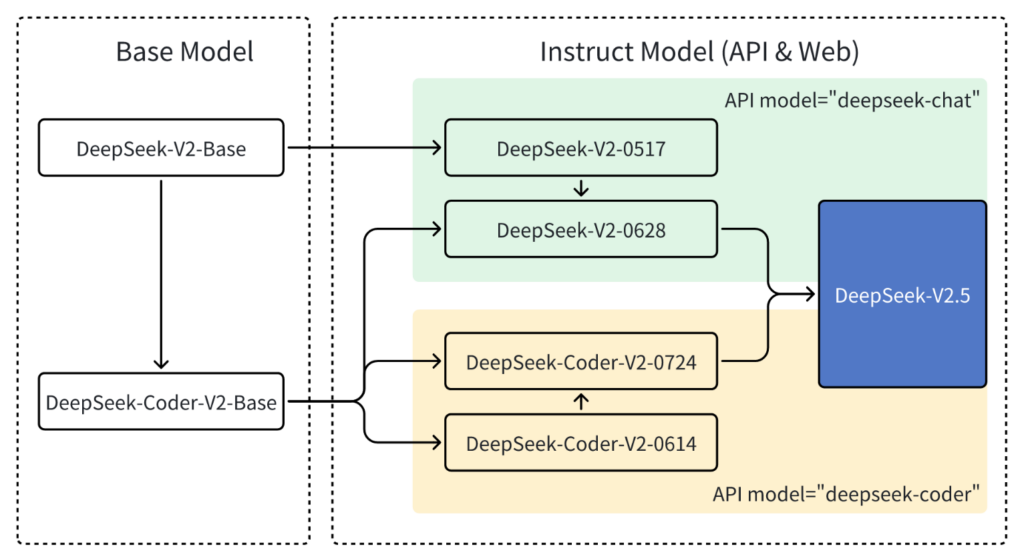

Modellarchitektur

Die Architektur des DeepSeek LLM basiert auf einem auto-regressiven Transformer-Decoder-Modell, ähnlich wie bei LLaMA. Das 7B-Modell verwendet Multi-Head Attention (MHA), während das 67B-Modell Grouped-Query Attention (GQA) einsetzt, um die rechnerische Effizienz zu steigern. Beide Modelle unterstützen eine Sequenzlänge von bis zu 4096 Tokens, was ihnen ermöglicht, umfangreiche Kontexte in Textdaten zu verarbeiten.

Trainingsprozess

- Vortraining: Die Modelle werden auf einem riesigen Datensatz von 2 Billionen Tokens in Englisch und Chinesisch vortrainiert. Diese Phase hilft dem Modell, allgemeine Sprachmuster und Wissen zu erlernen.

- Das Training nutzt den AdamW-Optimizer mit spezifischen Hyperparametern: β1 = 0,9, β2 = 0,95 und einer Gewichtung von 0,1. Die Lernrate wird mit einem Multi-Step-Scheduler angepasst.

- Das 7B-Modell verwendete eine Batch-Größe von 2304 und eine Lernrate von 4,2e-4, während das 67B-Modell eine Batch-Größe von 4608 nutzte.

- Überwachtes Fein-Tuning (SFT): Nach dem Vortraining durchlaufen die Modelle ein überwachtetes Fein-Tuning unter Verwendung von Instruktions-Antwort-Paaren. DeepSeek sammelte etwa 1,5 Millionen Beispieldaten von Instruktionen in Englisch und Chinesisch, um die Nützlichkeit bei Aufgaben wie Programmieren und Mathematik zu verbessern.

- Bemerkenswert ist, dass sie während der SFT-Phase 20 Millionen chinesische Multiple-Choice-Fragen hinzufügten, was die Leistung des Modells bei Multiple-Choice-Aufgaben erheblich steigerte.

- Verstärkendes Lernen (RL): Um die Leistung weiter zu verbessern, nutzt DeepSeek verstärkendes Lernen.

- Sie verwenden eine Methode namens Group Relative Policy Optimization (GRPO), die intern entwickelt wurde.

- GRPO funktioniert, indem eine Gruppe von Ausgaben (Schlussfolgerungsprozess und Antwort) für eine Eingabe abgerufen wird und das Modell darauf trainiert wird, bevorzugte Optionen basierend auf vordefinierten Regeln zu erzeugen.

Belohnungen werden basierend auf Genauigkeit und anderen Faktoren vergeben.

- Das Training von DeepSeek-R1 umfasst vier verschiedene Phasen: initiales überwaches Fein-Tuning, verstärkendes Lernen mit dem Fokus auf Schlussfolgerung, Sammlung neuer Trainingsdaten mit Ablehnungssampling und abschließendes verstärkendes Lernen über verschiedene Aufgaben. Ablehnungssampling und überwaches Fein-Tuning werden verwendet, um eine große Anzahl an Proben zu erzeugen, und ein Belohnungsmodell wird eingesetzt, um die besten auszuwählen.

Parameteroptimierung

Eine bemerkenswerte technische Innovation im Ansatz von DeepSeek betrifft die Optimierung der Parameterpräzision. Traditionelle Modelle nutzen in der Regel eine 32-Bit-Präzision zur Darstellung der Verbindungen im neuronalen Netzwerk. DeepSeek hat erfolgreich ein 8-Bit-Präzisionssystem implementiert, was sowohl den Speicher- als auch den Rechenaufwand während der Trainingsphase drastisch reduziert. Während eine solche Präzisionsreduktion normalerweise das Risiko einer Genauigkeitsminderung mit sich bringt, hat DeepSeek fortschrittliche Techniken entwickelt, um die Leistungsqualität zu erhalten und gleichzeitig von den reduzierten Ressourcenkosten zu profitieren.

Verbesserte Token-Vorhersage

DeepSeek hat auch den Token-Vorhersageprozess revolutioniert. Traditionelle Sprachmodelle erzeugen Antworten sequenziell und produzieren jeweils einen Token nach dem anderen. Die Innovation von DeepSeek ermöglicht die gleichzeitige Vorhersage mehrerer aufeinanderfolgender Tokens, was zwei wesentliche Vorteile mit sich bringt: verbesserte Inferenzqualität und reduzierte Rechenaufwände bei der Generierung vollständiger Antworten.

Auswirkungen auf die Industrie

Diese Innovationen stellen einen bedeutenden Wandel im Ansatz zur Entwicklung von KI-Modellen dar. Während viele Unternehmen sich darauf konzentrieren, Hardware-Ressourcen zu skalieren, um bessere Leistung zu erzielen, zeigt DeepSeek, dass durch architektonische und algorithmische Innovationen erhebliche Verbesserungen erzielt werden können. Ihr Ansatz adressiert nicht nur die aktuellen Einschränkungen bei der Bereitstellung von KI, sondern eröffnet auch neue Möglichkeiten für effizientere und zugänglichere KI-Systeme.

Vergleichende Leistung von fünf KI-Modellen über fünf Benchmarks (Arena-Hard, MMLU-Pro, GPQA-Diamond, LiveCodeBench, LiveBench) bis zum 31.08.2024, unter Verwendung einer nicht spezifizierten Metrik, bei der höhere Werte eine bessere Leistung anzeigen.

OpenAI: Der etablierte Marktführer

OpenAI hingegen bleibt eine dominante Kraft in der KI-Welt. Sie haben bahnbrechende Technologien wie GPT-4 und DALL-E ins Leben gerufen, und ihre Modelle werden sowohl in kommerziellen als auch in wissenschaftlichen Bereichen weit genutzt. OpenAIs Ansatz ist hauptsächlich proprietär; während sie über APIs und Dienstleistungen Zugang gewähren, bleiben die zugrunde liegenden Modelle und Trainingsdaten in der Regel geheim.

Der Erfolg von OpenAI beruht auf erheblichem Funding und einer Geschichte der Innovation. Ihre Position als Marktführer hat es ihnen ermöglicht, den Rahmen für aktuelle KI-Trends zu setzen und auch die Richtung des Feldes zu beeinflussen.

In jüngsten Entwicklungen im Bereich der künstlichen Intelligenz (KI) untersuchen OpenAI und ihr großer Investor, Microsoft, ob das chinesische KI-Start-up DeepSeek OpenAIs proprietäre Technologie unrechtmäßig genutzt hat, um eigene KI-Modelle zu entwickeln. Diese Untersuchung hebt die Komplexität von geistigen Eigentumsrechten und ethischen Überlegungen in der sich schnell entwickelnden KI-Industrie hervor.

Hintergrund zu DeepSeek und OpenAI

OpenAI, bekannt für seine fortschrittlichen KI-Modelle wie ChatGPT, ist ein führendes Unternehmen in der KI-Forschung und -Entwicklung. DeepSeek, ein relativ neuer Akteur, hat schnell Aufmerksamkeit erregt mit seinem KI-Assistenten R1, der ChatGPT in den Downloads im Apple App Store übertroffen hat. Dieser rasche Aufstieg hat Bedenken hinsichtlich der Methoden aufgeworfen, die bei der Entwicklung von R1 verwendet wurden.

Die Vorwürfe

OpenAI vermutet, dass DeepSeek unbefugt Daten genutzt hat, um R1 zu trainieren. Insbesondere gibt es Bedenken, dass DeepSeek eine Technik namens „Distillation“ verwendet hat, bei der ein kleineres Modell mit den Ausgaben eines größeren, fortschrittlicheren Modells trainiert wird. Dieser Ansatz kann die Leistung verbessern, könnte jedoch geistige Eigentumsrechte verletzen, wenn er ohne ordnungsgemäße Genehmigung durchgeführt wird.

Die Untersuchung

Microsoft entdeckte ungewöhnliche Aktivitäten im Zusammenhang mit der Nutzung einer OpenAI-API und informierte OpenAI über den möglichen Verstoß. Die Untersuchung ist noch im Gange, wobei beide Unternehmen prüfen, ob DeepSeek Beschränkungen umgangen hat, um große Mengen an Daten zu erlangen, was möglicherweise die Nutzungsbedingungen von OpenAI verletzt.

Reaktionen aus der Branche

Die KI-Community äußerte Bedenken hinsichtlich der Auswirkungen dieses Falls. Experten heben die Herausforderungen hervor, geistiges Eigentum in einer Branche zu schützen, in der schnelle Innovation oft die regulatorischen Rahmenbedingungen überholt. Der Fall hat auch Diskussionen über die Notwendigkeit einer robusten KI-Governance und Exportkontrollen angestoßen, insbesondere im Hinblick auf mögliche militärische Anwendungen und Wettbewerbsvorteile.

Potenzielle Konsequenzen

Sollten die Vorwürfe gegen DeepSeek bestätigt werden, könnte das Unternehmen mit rechtlichen Schritten, einschließlich Klagen und Sanktionen, konfrontiert werden, die seine Aktivitäten und seinen Ruf beeinträchtigen könnten. Für OpenAI unterstreicht der Fall die Bedeutung der Implementierung strenger Maßnahmen zum Schutz seiner proprietären Technologie und könnte zu einer Neubewertung seiner Datensicherheitsprotokolle führen.

Breitere Auswirkungen auf die KI-Industrie

Dieser Vorfall beleuchtet das größere Problem der Technologie-Replikation im KI-Sektor. Er hebt die Notwendigkeit klarer Richtlinien und Vorschriften zum Schutz des geistigen Eigentums hervor, während gleichzeitig Innovationen gefördert werden. Der Fall betont auch die Bedeutung internationaler Zusammenarbeit bei der Etablierung ethischer Standards und Governance-Rahmenwerke, um die komplexe Landschaft der KI-Entwicklung zu navigieren.

Unsere Expertenbewertung zu DeepSeek:

DeepSeek: Ein Game-Changer in der Open-Source-KI

Das DeepSeek-Modell sorgt in der KI-Landschaft für Aufsehen und zeigt beeindruckende Fähigkeiten, obwohl es mit einem deutlich kleineren Budget als proprietäre Giganten wie OpenAIs O1-Modell auskommt. Hier ist eine schnelle Übersicht:

Schlüssel-Highlights

💰 Kosteneffiziente Innovation:

DeepSeek kostete 6 Millionen Dollar in der Entwicklung, kann jedoch in vielen Bereichen mit OpenAIs 100 Millionen Dollar teurem O1-Modell konkurrieren.

Clever eingesetzte Strategien wie (wahrscheinlich) synthetische GPT-4.0-Trainingsdaten und Reverse-Engineering senkten die Kosten erheblich.

🤖 Leistungsfähigkeits-Insights:

Stark bei der Problemlösung und schrittweisen Argumentation, ideal für komplexe Aufgaben.

Langsamere Ladezeiten und begrenzte Verbesserungen beim kreativen Schreiben.

Unbekannte Leistung auf Deutsch.

🌐 Open-Source-Erfolg:

Der Open-Source-Ansatz ermöglicht das Hosting ohne Einschränkungen (z. B. chinesische Zensur).

Dies schließt die Lücke zwischen Open- und Closed-Source-KI-Modellen.

🔗 Relevanz für Content Creators:

Die kreative Inhaltserstellung hat mit GPT-4.0 bereits ihr Plateau erreicht.

DeepSeek punktet eher in logischem Denken und nicht in der Kreativität, was es derzeit weniger relevant für Content Creators macht.

Breitere Implikationen

🚀 Die Macht von Open-Source:

Open-Source-KI holt schnell auf und stellt das Spielfeld gleich.

📉 Marktverschiebungen:

Effiziente Modelle wie DeepSeek könnten die Nachfrage nach Hardware verändern – schlechte Nachrichten für NVIDIA (und deren Aktionäre).

🔎 Zukunftspotenzial:

Modelle wie DeepSeek deuten auf eine Zukunft hin, in der kostengünstige KI erfolgreich sein könnte (ca. 5 % der Kosten im Vergleich zu OpenAI-Modellen).

DeepSeek ist ein faszinierender Schritt nach vorne und beweist, dass beeindruckende Innovationen nicht immer massive Budgets erfordern. Es ist eine spannende Entwicklung für die KI-Community und definitiv eine, die man im Auge behalten sollte.

Außerdem, in Bezug auf KI-generierte Bilder, ist das neue Bildmodell von DeepSeek (das im Browser läuft), aber es ist ziemlich schlecht. (Siehe Bild)

DeepSeek: Sicher in der Anwendung?

Es gibt keine direkten Berichte, die darauf hinweisen, dass DeepSeek in Bezug auf Sicherheit, Datenschutz oder Zuverlässigkeit unsicher ist. Allerdings gibt es einige Faktoren, die vor der Nutzung von DeepSeek berücksichtigt werden sollten, insbesondere im Hinblick auf die laufende Untersuchung von OpenAI und Microsoft bezüglich des möglichen unbefugten Einsatzes von OpenAIs Technologie:

- Bedenken bezüglich des Datenschutzes:

Die Datenschutzrichtlinie von DeepSeek besagt, dass Nutzerdaten auf Servern in China gespeichert werden, was Bedenken hinsichtlich des Zugriffs durch die chinesische Regierung aufwirft. DeepSeek sammelt Nutzerdaten, einschließlich Geräteinformationen, Tastenanschlagmuster und IP-Adressen, die potenziell exponiert oder missbraucht werden könnten. Internationale Datenschutzbehörden untersuchen DeepSeek ebenfalls, insbesondere im Hinblick auf den Umgang mit Nutzerdaten. - Potenzial für Missbrauch:

Wie bei jeder leistungsstarken KI besteht auch bei DeepSeek die Möglichkeit, dass Modelle für böswillige Zwecke eingesetzt werden, etwa zur Erstellung von Fehlinformationen oder für Einflusskampagnen. - Zensurbedenken:

Einige Nutzer berichteten, dass DeepSeek Fragen zu politisch sensiblen Themen, insbesondere solche im Zusammenhang mit China, zensiert oder vermeidet. Dies wirft Bedenken hinsichtlich von Bias und Propaganda auf. - Cybersicherheit:

DeepSeek hat in der Vergangenheit groß angelegte, bösartige Angriffe erlebt, was auf potenzielle Schwachstellen in ihren Systemen hinweist.

Was bedeutet das für dich?

Egal, ob du Entwickler, Forscher oder Gelegenheitsnutzer bist – der Wettbewerb zwischen DeepSeek und OpenAI hat wichtige Implikationen:

- Erhöhter Zugang zu KI-Tools:

Das Aufkommen von Open-Source-Modellen wie DeepSeek wird zu einem breiteren Zugang zu leistungsstarken KI-Tools führen, was Innovationen in verschiedenen Bereichen anstoßen könnte. - Mehr Transparenz:

Open-Source-Projekte fördern Transparenz und Zusammenarbeit, was der gesamten KI-Community zugutekommt. - Mehr Auswahlmöglichkeiten:

Nutzer haben künftig mehr Optionen, wenn es darum geht, die richtigen KI-Tools für ihre Bedürfnisse auszuwählen. - Erhöhte Wachsamkeit:

Sei vorsichtig in Bezug auf den Datenschutz und bleibe über die potenziellen Risiken informiert, die mit der Nutzung von KI-Plattformen verbunden sind, insbesondere bei der Nutzung neuerer Plattformen wie DeepSeek.

Empfehlungen zur Verwendung von DeepSeek:

- Sei vorsichtig mit den Daten, die du teilst:

Angesichts der Datenschutzbedenken solltest du vermeiden, sensible oder persönliche Informationen in deinen Interaktionen mit DeepSeek preiszugeben. - Bleib informiert:

Halte dich über die neuesten Nachrichten und Entwicklungen in Bezug auf DeepSeek und seine Sicherheitspraktiken auf dem Laufenden. - Sei dir möglichem Bias bewusst:

Erkenne, dass DeepSeek’s Antworten durch Zensur oder Bias beeinflusst sein könnten, besonders bei Themen im Zusammenhang mit China. - Zieh Alternativen in Betracht:

Wenn Datenschutz ein wichtiges Anliegen für dich ist, solltest du andere KI-Tools und Plattformen von Anbietern in Betracht ziehen, die transparentere und benutzerfreundlichere Datenschutzrichtlinien bieten. - Nutze es auf eigenes Risiko:

Verstehe, dass die Nutzung von DeepSeek auch das Akzeptieren potenzieller Risiken im Hinblick auf Datenschutz, Sicherheit und Zensur bedeutet.

Worauf du achten solltest:

- Modellleistung:

Wie sich DeepSeek’s Modelle weiterentwickeln und wie sie im Vergleich zu OpenAIs abschneiden. - Lizenzänderungen:

Ob DeepSeek seine Open-Source-Philosophie beibehält oder anpasst. - OpenAIs Reaktion:

Wie OpenAI seine Strategien und Angebote angesichts des Wettbewerbs von Open-Source-Modellen anpasst. - Die breitere KI-Landschaft:

Wie diese Dynamik die Gesamtentwicklung und den Zugang zu KI-Technologien beeinflusst.

Fazit

DeepSeek ist eine leistungsstarke und sich schnell entwickelnde KI-Plattform mit innovativer Technologie, bringt jedoch eigene Risiken im Bereich Datenschutz, Missbrauchspotential und Zensur mit sich. Es ist entscheidend, sich dieser Faktoren bewusst zu sein und Vorsicht walten zu lassen, wenn man ihre Produkte nutzt.